Ciencia y Tecnología

Armas robóticas: ¿Deberían eliminarse?

Un grupo de 116 expertos en tecnología ha firmado una carta dirigida a las Naciones Unidas para prohibir el uso de robots militares. Pero, ¿realmente está fundamentado ese miedo? El debate está servido

Un grupo de 116 expertos en tecnología ha firmado una carta dirigida a las Naciones Unidas para prohibir el uso de robots militares. Pero, ¿realmente está fundamentado ese miedo? El debate está servido.

n total son 116 firmas, entre ellas las de Elon Musk de Tesla o el creador del sistema de inteligencia artificial Google Deepmind, Mustafa Suleyman, quienes han firmado una carta, dirigida a las Naciones Unidas, más precisamente al Grupo de Armas de la organización, para prohibir el uso de este tipo de tecnología en conflictos bélicos. Los responsables de la iniciativa son científicos y empresarios vinculados al sector de la robótica y la inteligencia artificial.

La misiva describe el riesgo de los robots armados y señala que se debe tomar acción de modo inmediato contra ellos. ¿Por qué ahora? Básicamente porque la semana pasada debían reunirse los responsables del grupo de oficiales de las Naciones Unidas que iban a considerar agregar armas robóticas a la Convención de las Naciones Unidas sobre Armas. Se trata de una convención que data de 1981 y que actualmente restringe el uso de armas químicas, minas antipersonas, armas láser y todo arsenal que provoque «innecesaria e injustificadamente sufrimiento en los combatientes o en la población civil». Por extraño que suene.

«Las armas letales autónomas –explican los autores en la carta– amenazan con convertirse en la tercera revolución en la guerra. Una vez desarrolladas, permitirán que el conflicto armado se libere a una escala nunca vista y en un periodo de tiempo más rápido de lo que los humanos podemos comprender. Pueden ser armas de terror, armas que los déspotas y los terroristas usen contra poblaciones inocentes y armas hackeadas para comportarse de manera indeseable. No tenemos mucho tiempo para actuar. Una vez que se abra la caja de Pandora, será difícil cerrarla. Necesitamos encontrar una manera de protegernos de todos de estos peligros».

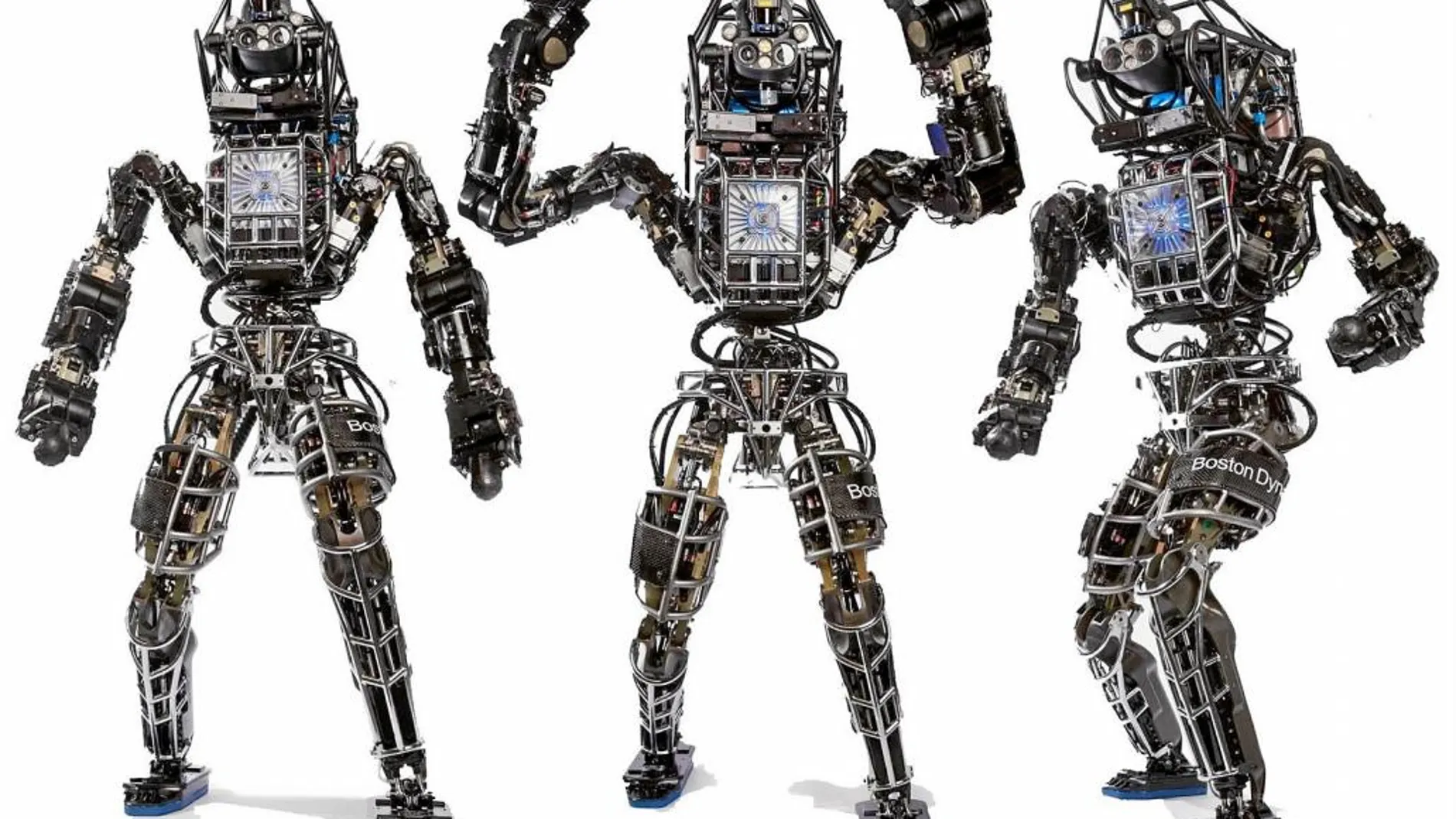

Las armas de las que hablan los expertos incluyen robots como Qinetiq (capaz de cargar hasta 400 rondas de balas y a un soldado herido, con una autonomía de hasta 12 horas... al tiempo que dispara munición de gran calibre o granadas), drones bautizados como Destripador (Reaper drone) y cañones inteligentes como el Raytheon. Todos ellos equipados con sistemas de inteligencia artificial y aprendizaje profundo (deep learning).

Muchos señalan que estos guerreros robóticos podrían reducir las bajas entre soldados, al menos aquellos de las naciones más avanzadas que puedan pagarlos. Su puntería permitiría dirigir con mayor precisión los blancos y evitar heridos o bajas entre la población civil. También, debido a su capacidad de carga, pueden trasladar heridos desde el campo de batalla y hasta actuar como pequeñas unidades médicas móviles.

Para los firmantes de la carta, sin embargo, el principal riesgo es para la población civil. Pero esto, como veremos más adelante, no es tan así.

Uno de los pioneros en el campo de la inteligencia artificial, Yoshua Bengio, también ha opinado al respecto, afirmando que carrera armamentística de la inteligencia artificial podría resultar «perjudicial para el desarrollo de buenas aplicaciones de IA». Precisamente aquí está la clave.

La reunión del grupo de las Naciones Unidas, estipulada para el 21 de agosto se ha cancelado hasta noviembre. Y eso nos lleva a considerar varias preguntas. La más lógica de todas ellas es por qué personalidades del mundo tecnológico, científico y empresarial parecen estar tan en contra de la inteligencia artificial.

La realidad es que no están en contra de la inteligencia artificial, sino, sencilla y lógicamente, de su uso con fines bélicos. En este sentido, Toby Walsh, profesor de esta disciplina en la Universidad de Nueva Gales del Sur y otro de los firmantes afirma que «casi todas las tecnologías se pueden utilizar para bien y para mal, y la inteligencia artificial no es diferente. Puede ayudar a resolver muchos de los problemas apremiantes que enfrenta la sociedad actual: la desigualdad y la pobreza, los desafíos planteados por el cambio climático y la actual crisis financiera mundial. Sin embargo, la misma tecnología también se puede utilizar en armas autónomas para industrializar la guerra». Básicamente esto quiere decir que al igual que internet no es mala sino el uso que se hace de ella puede serlo, lo mismo ocurre con la IA, una disciplina que tiene el potencial de influir de modo decisivo en campos tan distantes como el arte, la economía, la medicina o el deporte.

También es fundamental destacar que la inteligencia artificial que llevan estos robots no es la misma que poseen los coches autónomos, habilitados para tomar decisiones por sí mismos. Los «robots soldados» recurren al GPS, a comandos de voz, instrucciones a distancia y a datos obtenidos en la Nube, pero no tienen capacidad para decidir. De hecho, la mayoría de ellos están controlados por un ser humano.

¿Por qué la alerta? Como afirma Walsh «casi todas las tecnologías pueden usarse para el bien o para el mal». La ingeniería genética, internet, la energía nuclear... Con muchas tecnologías nos hemos perdido la oportunidad de regular y hasta legislar su uso. La Inteligencia artificial, en muchos sentidos, está dando sus primeros pasos y por ello es tan importante crear una serie de alertas, para comenzar a establecer controles y hasta posibles leyes que determinen su uso y así lograr la garantía de que estarán destinadas a un buen fin.

✕

Accede a tu cuenta para comentar