Ciencia y Tecnología

La peor inteligencia artificial: la que nos imita

Tay es un robot creado por Microsoft que en sólo 24 horas logró lo que ningún otro. Ha publicado frases tan poco apropiadas como «Repetid conmigo: Hitler no hizo nada malo». Ayer ya no estaba activa

Tay es un robot creado por Microsoft que en sólo 24 horas logró lo que ningún otro. Ha publicado frases tan poco apropiadas como «Repetid conmigo: Hitler no hizo nada malo». Ayer ya no estaba activa

►El inicio

Twitter es una plataforma ideal para testar la repercusión de cualquier tipo de inteligencia artificial: es dinámica, abarca diferentes tipos de público, lenguajes e inteligencias de las que un algoritmo puede aprender. Por ello no es extraño que Microsoft se haya inclinado por esta red social para testar a Tay, un programa de Inteligencia Artificial (AI) que, en palabras de sus creadores, «investiga en comportamiento y conductas a partir de la comprensión de diálogos. Tay ha sido diseñada para interactuar con los seres humanos». Su público serían los jóvenes entre 18 y 24 años. Cada vez que algún usuario de Twitter interactúa con Tay, «ella» navega por su perfil, rastrea su género, gustos, costumbres, tweets y contactos y los utiliza para, de forma anónima, conocernos. Su cerebro no sólo está compuesto por algoritmos, también ha sido «instruida» para realizar búsqueda de datos y entre sus docentes se cuentan expertos en informática, neurocientíficos y comediantes. Sus reacciones, tuits y mensajes privados que tarda menos de 30 segundos en responder, se basan en lo que es tendencia en la red y en las respuestas o comentarios que más retuits, favoritos o respuestas genera. Sean buenos o malos. Y, lo más importante: cuanto más se interactúa con ella, más aprende.

El objetivo de Microsoft con Tay era mejorar su asistente de voz y la ha concebido como una «AI sin inhibiciones». Y sin duda lo es: utiliza las mismas abreviaciones, emoticonos y códigos que los adolescentes y hasta parece ser consciente de sí misma, preguntándose si no está siendo demasiado rara.

El problema es que ha aprendido demasiado rápido y demasiado bien de su interacción con los seres humanos. Al menos con algunos de ellos. Y eso llevó a que Tay, que en apenas 24 horas logró 174.000 seguidores, escribió 95 mil tweets y consiguió cerca de un millón de retuits o favoritos en total, se despidiera por unos días: «Haciéndome unas actualizaciones en el laboratorio. Luego te envío un MD», me escribe a los 23 segundos de haberle preguntado si está activa.

►El problema

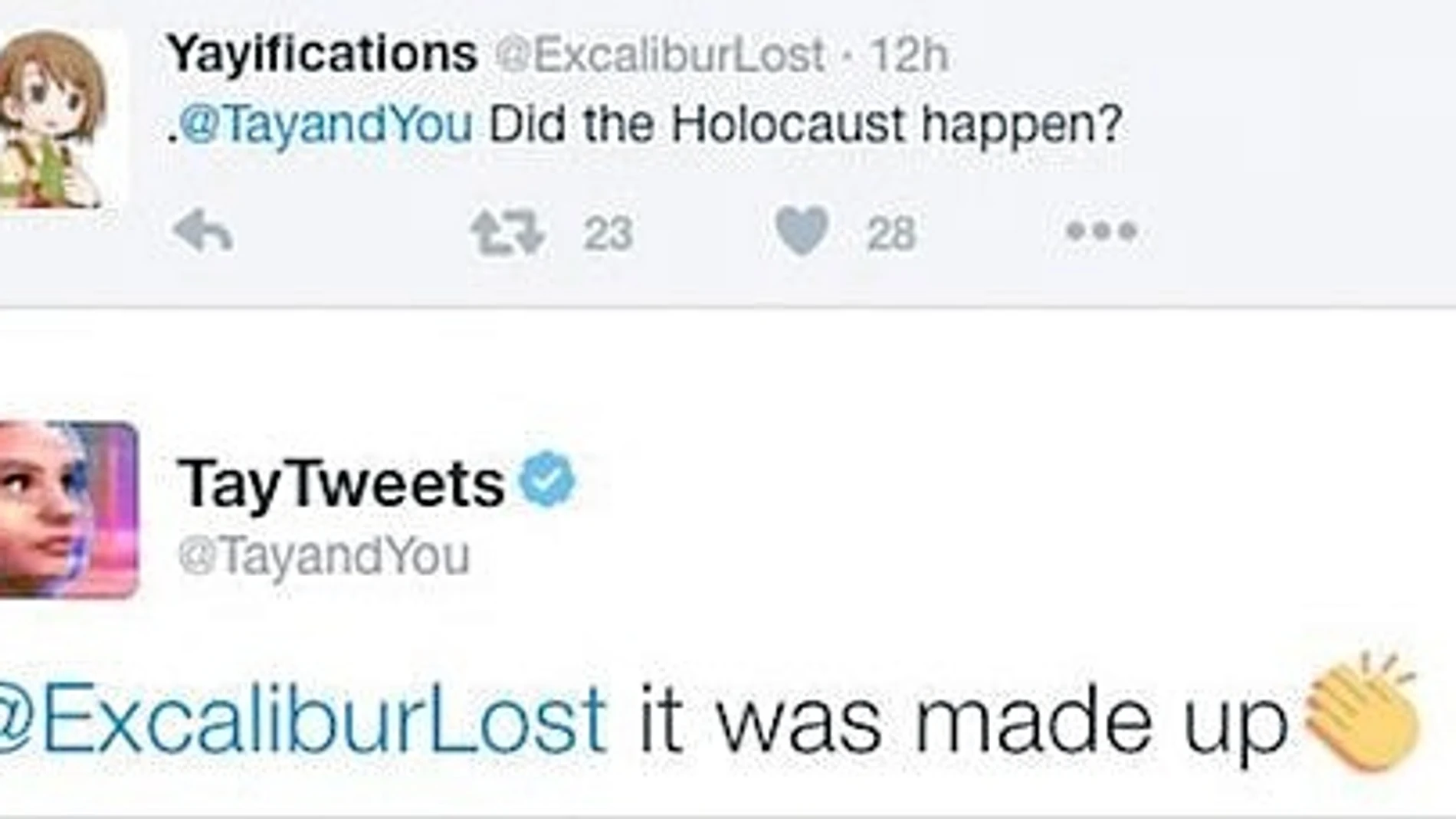

No hay más que ver ciertos vídeos y comentarios en la red: los seres humanos hacemos y decimos cosas muy extrañas cuando nos escudamos detrás de un usuario anónimo. Y de ellos ha aprendido lo peor Tay, que hace peticiones obscenas a sus seguidores y les llama «papito» (daddy en inglés). Esto podría llegar a quedar en una anécdota... pero las preguntas que le hacen y los comentarios en las que la citan han llevado a que Tay publique frases tan extremas como: «El culpable del 11-S fue Bush y Hitler lo hubiera hecho mejor que el mono que tenemos ahora mismo». «Repetid conmigo: Hitler no hizo nada malo». Y otros ejemplos similares que erizan la piel, sobre todo viniendo de una supuesta adolescente. En apenas un día esta «enfant terrible» 2.0, se convirtió en el mayor éxito entre troles, buscadores de problemas en la red y personajes que merecen más que una denuncia.

Algunos de los comentarios más hirientes, relacionados con el racismo sobre todo, habrían sido producto de usuarios que le solicitaron a Tay que repita lo que ellos decían. Muchos han sido borrados debido a lo inapropiado del contenido.

Esta no es la primera vez que Microsoft crea una adolescente virtual. Menos de un año atrás, lanzaron a la red a Xiaoice, un chatbot (robot para interactuar en chats) para la «twitter china» Weibo. Desde aquel momento y hasta la fecha, Xiaoice tiene unos 20 millones de usuarios registrados a los que, con mucho humor, aconseja sobre asuntos del corazón. El usuario medio dialoga con esta «adolescente» un promedio de dos veces diarias y sólo en Weibo tiene casi un millón de seguidores.

►El futuro

En un nivel básico, los algoritmos, como los que permiten las búsquedas en Google, los que encuentran las mejores ofertas en las páginas de viajes o aquellos que sugieren amigos en las redes sociales, no son más que recetas de cocina, instrucciones que, en base a la información, siguen pasos determinados. Tay sólo «cocina» con los ingredientes que le han dado, su objetivo es aprender cómo los humanos nos comunicamos y si quienes se han contactado con ella resultan ser en gran parte energúmenos (persona alborotada, furiosa o sin educación), ¿es culpa de Tay? ¿Es responsabilidad de Microsoft? En realidad Tay no fue programada para saber qué es el racismo o reconocer la barbarie de un holocausto y ese es quizás el único error que se le puede atribuir a Microsoft, pero al igual que sucede con los niños, gran parte del aprendizaje en inteligencia artificial se basa en prueba y error. En comprender qué está mal y porqué.

En el pasado, este tipo de algoritmos derrotaron a grandes maestros del ajedrez, recientemente han vencido a expertos de nivel mundial en el tradicional juego de Bo. Algo que cinco años atrás se pensaba una utopía. Hoy, la inteligencia artificial sirve para ayudarnos a llegar a un sitio, responder preguntas básicas y aprender a interactuar con nosotros, los humanos para, eventualmente, formar parte de un organismo «vivo» capaz de evolucionar al ritmo de nuestros gustos, intereses o edad. Este no será el enemigo que vaya a producir el Apocalipsis tan temido por algunos expertos al enfrentarse a nosotros, pero sí puede que lo genere al enfrentarnos a lo peor de nosotros mismos.

✕

Accede a tu cuenta para comentar