Lenguaje

El «Big Bang» de la computación

Medio siglo atrás nacía Intel y con ella surgieron los primeros microprocesadores comerciales que dispararon la era informática.

Medio siglo atrás nacía Intel y con ella surgieron los primeros microprocesadores comerciales que dispararon la era informática.

Un día como hoy, pero de 1968, vio la luz la compañía Intel, pero todo comenzó en nueve años antes cuando Jack Kilby y Robert Noyce patentaron un circuito electrónico miniaturizado y un circuito integrado basado en silicio, respectivamente. A ellos se unió Gordon Moore, compañero de trabajo de Noyce y quien en 1965 publicó un artículo en «Electronics», cuyo título podría traducirse como «Atiborrar de componentes un circuito integrado» («Cramming More Components onto Integrated Circuits»). Pero volvamos al inicio...

La mejor analogía para comprender qué es un microprocesador es pensar en nuestro cerebro. Este órgano realiza sus funciones, básicamente abriendo y cerrando puertas (neuronas) que se conectan entre sí para enviar información. Dependiendo de a dónde lleguen los datos, es la tarea que se realiza. Un microprocesador, una suerte de cerebro informático, es el circuito integrado o microchip más complejo de un ordenador. Pero solo ejecuta tareas programadas. Allí se encuentra el circuito integrado que actúa como interruptor, abriendo y cerrando las puertas, y también los transistores, que serían, siguiendo con el símil anterior, las neuronas del cerebro: cuantas más tenga más «inteligente» será.

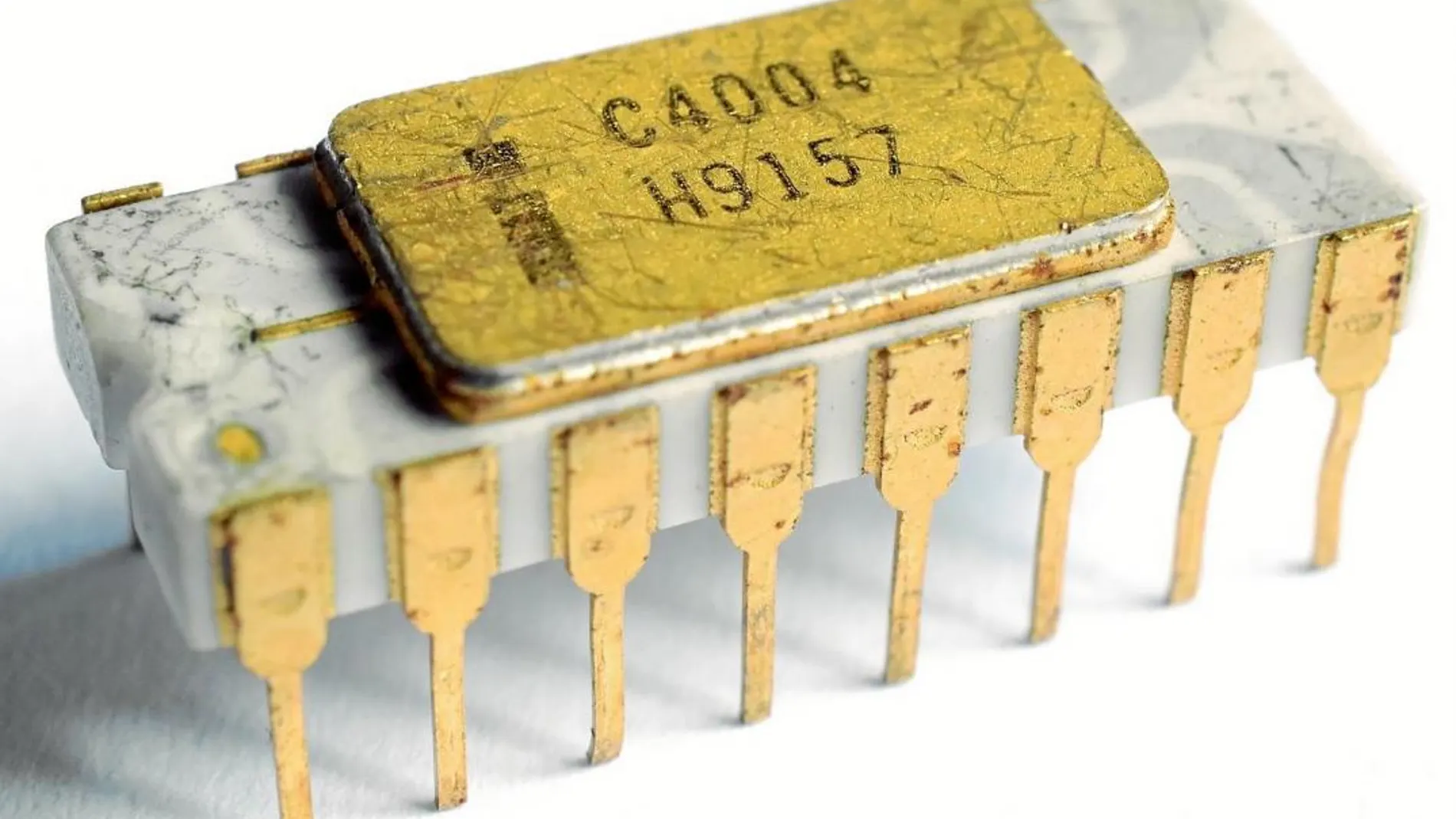

El Intel 4004 fue el primer microprocesador en un microchip. Contaba apenas con 2.300 transistores y era muy eficaz para tareas sencillas, como estar al mando de calculadoras electrónicas. Aún hoy hay semáforos que los tienen en su interior debido a su sencillez. En 1978, el Motorola 6809 alcanzaba los 9.000 transistores y apenas cuatro años después, con el Intel 80286, la cifra llegaba a los 134.000. A partir de ese momento comienza el gran salto: en 1989 el número de transistores se multiplica por diez y el Intel 80486 alcanza los 1.180.235, el equivalente, a grandes rasgos, a la capacidad de procesamiento de un gusano. Actualmente ya hablamos de 20 mil millones y nos acercamos a comparar la potencia de procesamiento con la de un ratón, el primer mamífero al que se podrían comparar nuestros ordenadores.

Pero, ¿cómo consiguieron los expertos pasar de 2.300 a diez millones de veces más? Sin tener límite de espacio, la respuesta es fácil. Pero, ¿cómo se sientan más pasajeros en un avión, cuando el tamaño es siempre el mismo? La respuesta la hemos vivido en carne propia: haciendo los asientos más pequeños. En informática esto se traduce en algo que hemos escuchado mucho en los últimos tiempos: tecnología nanométrica. Cuando se habla, por ejemplo, de un microchip de 14 nanómetros, la medida no se refiere al tamaño del microchip, sino al espacio que hay entre transistores: cuánto más pequeña es esta cifra, más «pasajeros» entran (siguiendo el símil del avión). Hoy ya hablamos de cinco nanómetros en casos experimentales, lo que permitiría ubicar 30.000 millones de transistores.

Hacer predicciones sobre lo que nos espera en los próximos 20 años es muy complejo. Sí sabemos que la computación cuántica incrementará la velocidad en miles de veces. También está la arquitectura, la potencia...y la biología. Esta semana un grupo de expertos, entre los que se encontraba el laboratorio de Margarita Salas nos ha acercado mucho más a la creación de una célula sintética, al lograr que replique su ADN. ¿Y si el próximo microchip fuera de carbono, como nosotros y no de silicio?

✕

Accede a tu cuenta para comentar

Experiencias en el extranjero