AGI

Google desarrolla una inteligencia artificial generalista y dice estar más cerca de alcanzar la humana

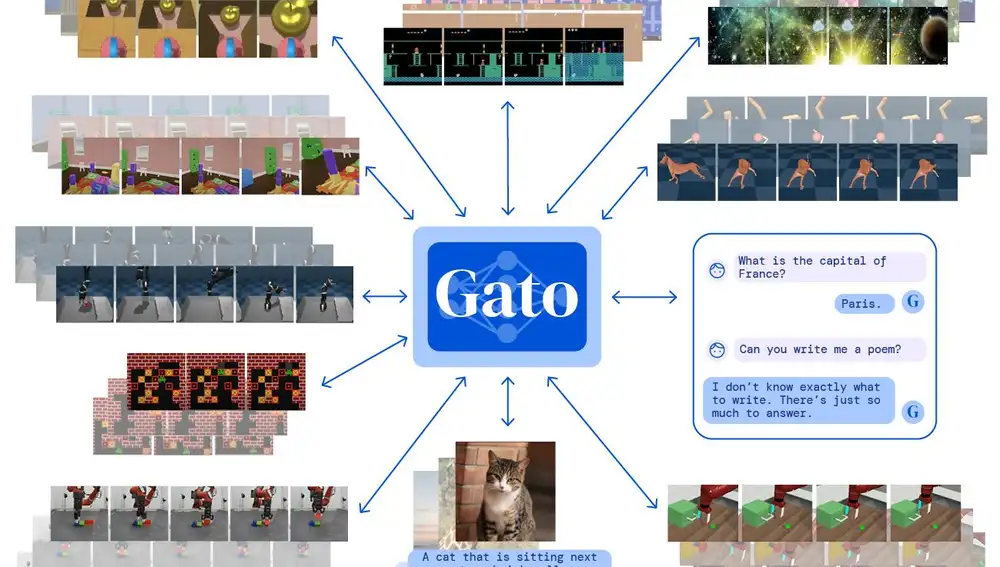

La inteligencia artificial Gato es un agente generalista capaz de realizar una amplia variedad de tareas complejas. Desde apilar bloques controlando un brazo robot a subtitular imágenes o jugar a Atari, entre más de seiscientas

Aunque el campo de la inteligencia artificial ha mostrado éxitos notables como GPT-3, un LLM (Large Language Model) que crea textos, o DALL-E, capaz de generar imágenes a partir de una breve descripción, la creación de un AGI (Artificial General Intelligence o inteligencia artificial generalista) que puede acometer una amplia variedad de tareas de la misma forma que un ser humano y sin necesidad de estar previamente familiarizada con ellas, se ha mostrado esquiva durante décadas. Un poco menos tras el anuncio de Google y DeepMind, compañía de IA perteneciente a la primera, de Gato, una inteligencia artificial de propósito general capaz de acometer más de 600 tareas que abarcan desde controlar un brazo robot y apilar bloques con él a subtitular imágenes, jugar a la videoconsola Atari o chatear, pero que ha despertado algunas suspicacias.

El medio especializado The Next Web respondió al anuncio de Gato con un artículo en el que cuestiona su consideración como AGI, dado que todavía depende de entrenamientos previos con conjuntos de datos para aprender a resolver una tarea y, en ese sentido, lo calificaba como un LLM con grandes resultados pero aún lejos de lo que se supone debe ser una inteligencia artificial generalista, a pesar de la diversidad de tareas que puede realizar.

En la misma línea, el investigador Mike Cook señalaba a TechCrunch sobre Gato que “esto puede parecer como que la IA puede preparar una taza de té o aprender fácilmente otras diez o cincuenta tareas, pero no puede hacer eso”.

Sin embargo, Nando de Freitas, investigador jefe de DeepMind, ha respondido a The Next Web señalando que “el juego ha terminado” y “ahora todo se trata de escala”. “Se trata de hacer que estos modelos sean más grandes, más seguros, más eficientes informáticamente, más rápidos en el muestreo, una memoria más inteligente, más modalidades, DATOS INNOVADORES, en/fuera de línea, ….”, ha declarado el investigador en Twitter.

En el paper publicado con su desarrollo, DeepMind explica que han aplicado un enfoque similar al de los modelos de lenguaje para que Gato “funcione como una política generalista multimodal y multitarea” de forma que una misma red neuronal puede “jugar a Atari, subtitular imágenes, chatear, apilar bloques con un brazo robótico real y mucho más, decidir en función de su contexto si generar texto, pares de torsión, pulsaciones de botones u otras acciones”. Aún así, y validando el argumento de The Next Web al distinguir entre una IA tradicional y una AGI, Deepmind señala que Gato “está entrenado en una gran cantidad de conjuntos de datos”.

A la pregunta que realizó el investigador de aprendizaje automático Alex Dimikas sobre cuanto tardaría Gato en superar un test de Turing, una prueba en la que un humano no puede distinguir entre el comportamiento de la máquina y una persona, De Freitas respondió que “todavía falta”.

✕

Accede a tu cuenta para comentar