Neurociencia

La IA podría estar tan lejos de ser autoconsciente como una calculadora (según este sencillo argumento)

La inteligencia y la conciencia podrían estar mucho menos relacionadas de lo que imaginamos

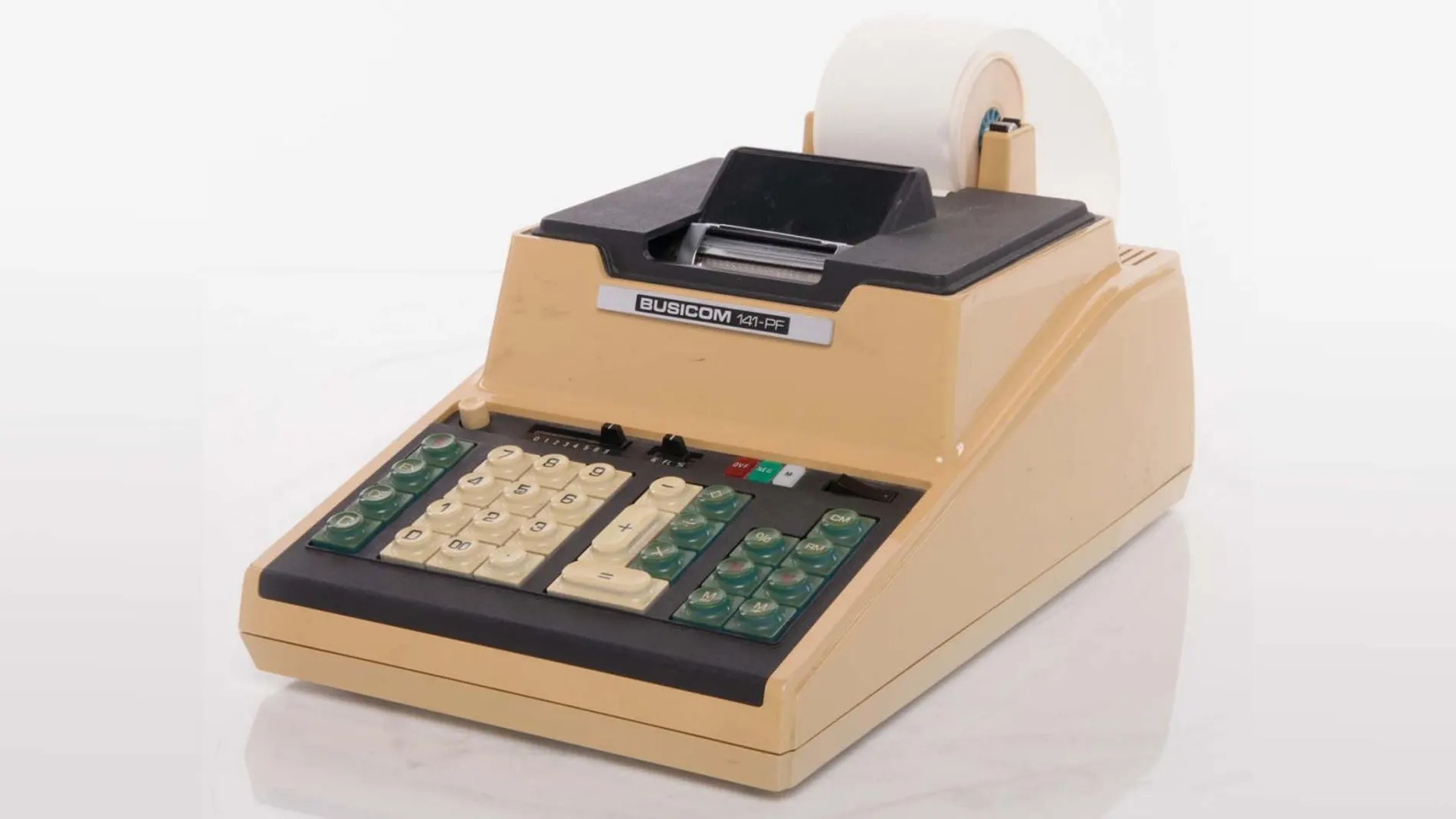

Aunque parezca mentira, las primeras calculadoras digitales transmitían cierto aire de inteligencia. Aquellos aparatos eran capaces de resolver, en un instante, cálculos casi imposibles para los humanos, aunque ahora, tan acostumbrados a la revolución electrónica, nos parecen reglas de cálculo venidas a más. Durante estos años, las calculadoras más básicas dieron paso a otras más sofisticadas, a ordenadores cada vez más poderosos y, finalmente, a algoritmos de inteligencia artificial en los que volvemos a sospechar una suerte de inteligencia. Es de esperar que la tecnología continúe avanzando y, por lo tanto, vale la pena preguntarnos cuánta “inteligencia” más puede adquirir una IA antes de desarrollar conciencia.

Y, si entrecomillamos la palabra “inteligencia” es porque no está claro que las respuestas de una IA puedan considerarse inteligentes. Por consenso, se suele decir que la IA es capaz de comportarse como si fuera inteligente (lo sea o no). No obstante, la mayoría de las definiciones de “inteligencia” suelen hacer referencia a la capacidad para adaptar las respuestas al contexto y la experiencia. Podríamos hablar de una capacidad plástica de resolver problemas que, si bien no tenían aquellas antiguas calculadoras, sí tienen nuestros modelos de lenguaje modernos. Partiendo de esta definición, parece razonable defender que, por lejos que estemos de una conciencia digital, las IAs están mucho más cerca de desarrollarla que una vulgar calculadora.

Emergencia por sorpresa

Exploremos esta definición amplia de “inteligencia”. Existen seres vivos realmente sencillos que la cumplen, como pueden ser algunos microorganismos que tienden a acercarse a las fuentes de alimento y alejarse de determinados peligros. No razonan, podríamos decir que no piensan, pero en ellos hay, tal vez, una de las formas más simples de inteligencia. Entre este ejemplo y nosotros hay todo un gradiente de inteligencias y, si tuviéramos que situar a la IA en algún punto de ese continuo, estaría más cerca de nosotros que de aquellos microorganismos. Ahora bien… ¿es la IA más inteligente que un microorganismo? Partiendo de la definición anterior… sí, claro. ¿Es más inteligente que una lombriz de tierra? ¿Y más que una culebra o un gorrión? Podríamos decir que sí.

Incluso si queremos compararla con nosotros nos veremos obligados a reconocer que, desde luego, la IA es más inteligente que algunas personas, incluso si todavía no ha desarrollado conciencia de sí misma. Y he aquí el problema. Aunque algunos antropólogos se resisten a aceptarlo, la etología ha acumulado una enorme cantidad de pruebas sobre la conciencia en otras especies animales. Sabemos que hay una suerte de autoconciencia en otros mamíferos, incluso en aves y reptiles. Tal vez esté más discutido en el caso de los invertebrados, pero sea como fuere, es muy probable que haya especies autoconscientes que has considerado menos inteligentes que ChatGPT o DeepSeek. ¿Cómo es esto posible? ¿Podría ser que ya hayamos alcanzado el “grado de inteligencia” necesario para que las IAs desarrollen consciencia? ¿Debemos concluir que ya son autoconscientes? Existe una explicación más plausible y menos inquietante.

Consciencia sin inteligencia

A no ser que queramos torturar la definición de inteligencia hasta convertirla en un sinónimo de “autoconsciencia”, estamos hablando de conceptos diferentes. Y, si no guardan una relación de identidad… ¿Y si la autoconsciencia no fuera una consecuencia inevitable del aumento de la inteligencia? ¿Y si del mismo modo que creemos posible la existencia de inteligencias no autoconscientes fuera posible la de autoconsciencias no inteligentes? Aflojar la relación entre estos dos conceptos sugiere preguntas profundas y complejas que tal vez ocupen otro artículo, pero para el propósito que nos ocupa no necesitamos ahondar tanto en la cuestión. Nos basta con preguntarnos, entonces, cuáles son los requisitos necesarios y suficientes para que emerja una consciencia.

Cabe la posibilidad de que la inteligencia ser un factor importante, puede que incluso necesario, pero no suficiente, el individuo inteligente ha de tener otras características para que de él emerja la consciencia. Es difícil saber cuáles son esas características, pero parece razonable imaginar que, al menos algunos de esos factores necesarios podrían ser aquellos que diferencian un cerebro humano de un algoritmo de inteligencia artificial. Nuestros cerebros no son simples ordenadores, el sustrato de nuestras “ideas” es mucho más complejo que las redes neuronales que hay tras una IA. Las curvas en la superficie de una neurona, las irregularidades de su membrana, la inestabilidad del potencial eléctrico en sus bombas de sodio-potasio… aparentes fruslerías que, sin embargo, sabemos que afectan a la manera en que dichas neuronas interaccionan.

¿Y si para viajar desde las calculadoras hasta las IAs hemos seguido un camino equivocado? Equivocado, al menos, si pretendemos llegar con el a la conciencia. Puede que el sustrato en el que se fundamentan nuestras ciencias de la computación sea insuficiente para dar a luz a una entidad autoconsciente. Puede que limite los futuros avances y los condene a aumentar en inteligencia sin acercarse ni un ápice a la autoconsciencia. Dicho en pocas palabras, el “sencillo argumento” que nombramos en el titular diría algo así como: la inteligencia (no importa cuánta) no es un requisito suficiente para la aparición de una autoconsciencia y, de hecho, tales requisitos podrían ser incompatibles con los fundamentos más básicos de nuestra tecnología.

QUE NO TE LA CUELEN:

- Si bien hay suficientes pruebas empíricas para afirmar con cierta seguridad que la autoconsciencia no surge solo de un aumento de la inteligencia, la segunda parte del argumento es solo plausible. Los verdaderos requisitos de la autoconsciencia podrían ser incompatibles con los fundamentos de las ciencias de la computación… o no. Por otro lado, nada de esto importa si, en lugar de hablar acerca de la IA puede desarrollar autoconsciencia, hablamos de si puede simularla de tal forma que, a todos los efectos, nos parezca tan consciente como cualquier hijo de vecino. Esa es una cuestión muy diferente.

REFERENCIAS (MLA):

- Ceruzzi, Paul E. A History of Modern Computing. MIT Press, 2003.

- Mashour, George A., y Michael T. Alkire. “Evolution of Consciousness: Phylogeny, Ontogeny, and Emergence from General Anesthesia.” Proceedings of the National Academy of Sciences, vol. 110, supl. 2, 2013, pp. 10357–10364. https://doi.org/10.1073/pnas.1301188110.

- Merker, Bjorn. “Consciousness without a Cerebral Cortex: A Challenge for Neuroscience and Medicine.” Behavioral and Brain Sciences, vol. 30, no. 1, 2007, pp. 63–81. https://doi.org/10.1017/S0140525X07000891.

- Perl, Yonatan Sanz, et al. “Non-Equilibrium Brain Dynamics as a Signature of Consciousness.” arXiv, 19 dic. 2020, https://arxiv.org/abs/2012.10792.

- Cabanac, Michel, Arnaud J. Cabanac, y André Parent. “The Emergence of Consciousness in Phylogeny.” Behavioural Brain Research, vol. 198, no. 2, 2009, pp. 267–272. https://doi.org/10.1016/j.bbr.2008.11.028.

- Betzel, Richard F., John D. Medaglia, y Danielle S. Bassett. “Diversity of Meso-Scale Architecture in Human and Non-Human Connectomes.” arXiv, 9 feb. 2017, https://arxiv.org/abs/1702.02807.

✕

Accede a tu cuenta para comentar