Estas son las novedades basadas en IA que Google trae al Buscador, Traductor y Lens

La compañía ha retransmitido un evento presentando las nuevas características, la mayoría avanzadas en el último Search On, y en el que el rival de ChatGPT, Bard, ha ocupado muy poco tiempo

Aunque el streaming de hoy estaba previsto desde hace semanas, el inesperado anuncio que Google realizó este lunes de Bard, la inteligencia artificial conversacional que preparan para posicionarse frente a ChatGPT, hizo pensar que el evento serviría para profundizar en ella. Pero no ha sido así, Bard ha ocupado muy poco tiempo y sin nada nuevo o demostraciones sobre lo ya avanzado. Lo mismo puede decirse del uso de IA generativa en los resultados de búsquedas de Google para preguntas NORA (No One Right Answer o para las que no hay una sola respuesta), en los que el contenido IA se mostrará como un resumen o sumario del tema antes del listado de webs. Así, los protagonistas de esta presentación centrada en la IA aplicada a productos y servicios de Google han sido el Buscador, el Traductor, Maps (cuyas novedades comentamos en este artículo) y Lens.

Novedades ha habido pocas. Sí un repaso a varias formas con las que la compañía está profundizando en el uso de inteligencia artificial para las aplicaciones mencionadas, algunas de las cuales fueron anunciadas en el último Search On realizado el pasado septiembre. Pero lo que entonces eran servicios a futuro ya han comenzado a desplegarse globalmente o están mucho más cerca de hacerlo.

Prabhakar Raghavan, vicepresidente senior de Google ha conducido el streaming en el que tan protagonista como la IA ha sido Lens, la aplicación de reconocimiento de imagen de Google que se convierte en la herramienta para habilitar capacidades potenciadas por IA en el traductor, las búsquedas y en Android en general.

Búsquedas mixtas de imagen y texto

La primera de ellas, anunciada en el pasado Search On, y que Google ya ha desplegado y puedes utilizar desde hoy mismo es Multisearch, bautizada en España como Búsquedas mixtas. Google, que ya se ha mostrado preocupada en el pasado por el creciente uso entre los más jóvenes de TikTok como buscador de información, cree que la búsqueda visual continuará ganado protagonismo en el futuro y Lens ayudará a mantener su terreno frente a la app de vídeos cortos.

A la ya conocida característica de enfocar un objeto para que Lens lo identifique y Google lo busque, se añadela capacidad de añadir parámetros de texto para definir mejor lo que se quiere. Para ello se enfoca con la cámara a un objeto, se pulsa en el icono de Lens y a continuación en el de la lupa para que la IA lo reconozca. Desplegando la pestaña de Coincidencias visuales que asoma en la parte inferior con los resultados, la aplicación muestra la imagen original seguida de una caja de texto con la opción Añadir algo a tu búsqueda. Las posibilidades son muy variadas, pero desde Google aconsejan usar pocos términos e introducirlos separados por comas.

Por ejemplo, si el objeto es una silla se puede añadir el color en el que se quiere encontrar u otra característica. O escribir Cerca de mí para que Google indique un sitio cercano para comprarla, pero este último parámetro solo está habilitado en Estados Unidos. Será ampliado al resto de usuarios en los próximos meses.

Las Búsquedas mixtas no se van a limitar a la cámara y Lens, sino que “en pocos meses” se ampliarán al Buscador de Google, de forma que será posible añadir parámetros de búsqueda a cualquier imagen que aparezca en la página de resultados.

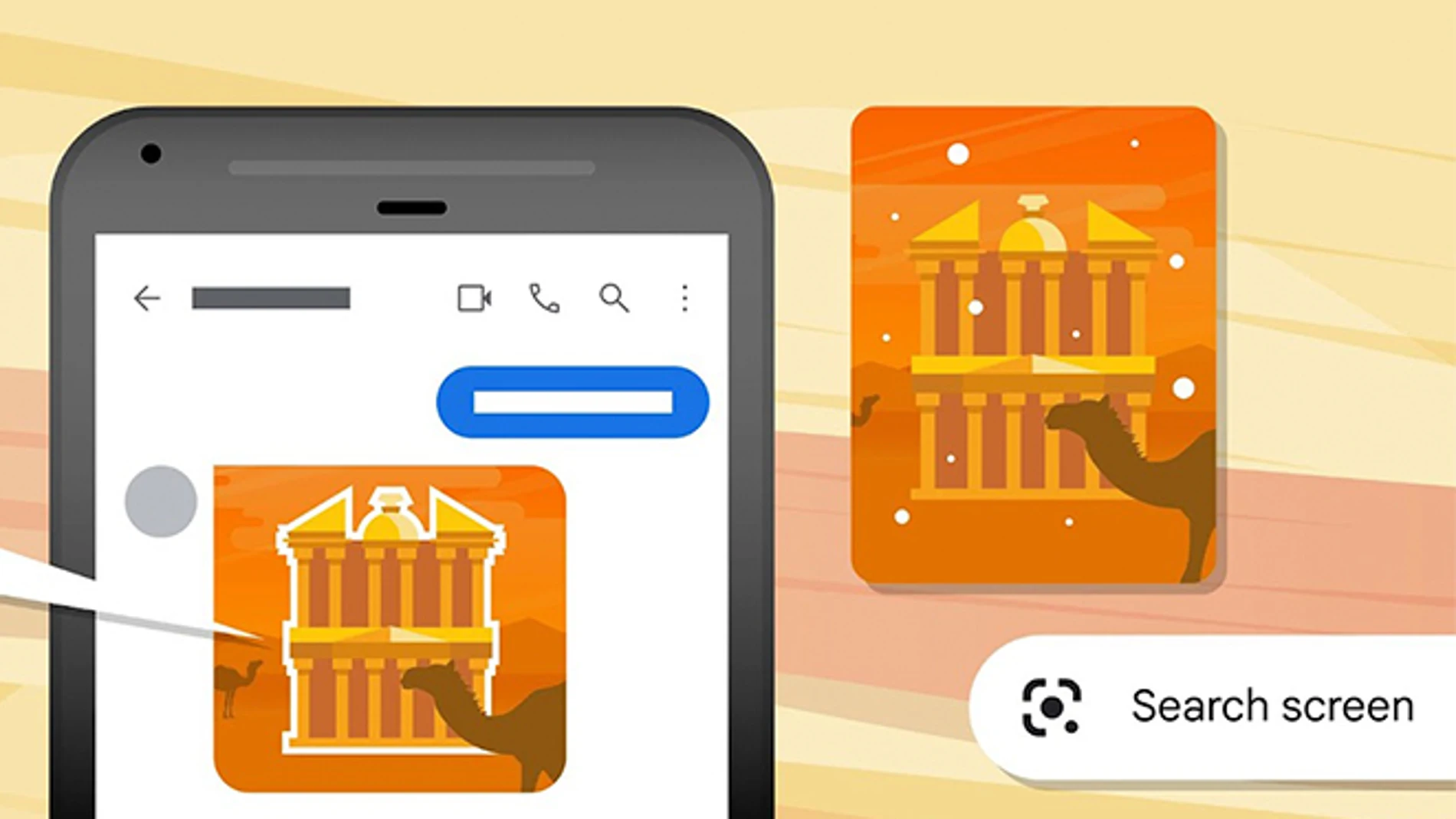

Búsquedas visuales de cualquier cosa que se muestre en la pantalla del móvil

Lens, que según Google se utiliza más de 10.000 millones de veces al mes, lleva las búsquedas aún más allá. La app, en un teléfono Android, podrá buscar cualquier cosa que aparezca en pantalla. Es decir, no solo lo que se enfoque con la cámara o lo que Lens identifique en una imagen guardada en la galería sino también en sitios web, vídeos y aplicaciones sin necesidad de interrumpir la experiencia de uso ni salirse de la app. Bastará mantener pulsado el botón de encendido o inicio del móvil y después pulsar en la opción Buscar pantalla para que Lens se ocupe.

Traducciones con más opciones y mejorada la de imágenes

El traductor de Google aumenta sus capacidades por IA y gana la de ofrecer opciones de traducción “con más contexto” añadiendo descripciones y ejemplos en el idioma al que se está traduciendo. Por ejemplo, si estás comprando una camiseta para indicar que la quieres de manga larga o de manga corta. Y lo hará empleando las palabras, incluyendo modismos locales, adecuadas a cada ocasión. Esta función estará disponible en las próximas semanas para los idiomas español, inglés, francés, alemán y japonés.

Otros 33 idiomas, entre los que se encuentra el vascuence, se añaden a los que están disponibles offline y que el traductor puede emplear sin conexión a Internet. Otra novedad anunciada el pasado Search On y que ahora se está desplegando globalmente es la traducción mejorada de imágenes. Hasta ahora, era posible tomar una imagen de un cartel, por ejemplo, y que el texto aparezca traducido al idioma de elección del usuario. La apariencia, era la de estar supuesto, pero con la ayuda de inteligencia artificial Lens recrea los píxeles del fondo de imagen tras las palabras traducidas para que encajen igual que en el original.

✕

Accede a tu cuenta para comentar