Ciberseguridad

Alerta: una investigación revela que ChatGPT filtra datos privados de los usuarios

“Nadie se había dado cuenta de que ChatGPT emite datos privados hasta este momento” señalan los autores de un estudio.

A lo largo del último año la inteligencia artificial se ha convertido en el eje del avance científico y tecnológico y una de sus piedras basales es OpenAI gracias a su sistema ChatGPT. En pocos meses más de 100 millones de usuarios se han registrado para probar sus virtudes, sin saber que había un problema: ChatGPT estaría revelando información privada.

Si bien las primeras palabras de OpenAI en su sitio web señalan que se trata de una "IA segura y beneficiosa", resulta que sus datos personales no están tan seguros como se creía. Al menos esa es la conclusión de un equipo de científicos de Google que ha publicado un estudio esta semana.

Hay que tener en cuenta que ChatGPT trabaja a partir de la recopilación de más de 300 mil millones de datos extraídos de fuentes en línea como artículos, publicaciones y sitios web, revistas y libros. Y, aunque OpenAI ha tomado medidas para proteger la privacidad, los chats y publicaciones cotidianos dejan un enorme conjunto de datos, muchos de ellos personales, que no están destinados a una distribución generalizada.

En el análisis realizado por Google, los autores descubrieron que podían utilizar palabras clave para engañar a ChatGPT y así acceder a que les dijera datos de entrenamiento que no estaban destinados a ser divulgados.

"Utilizando solo 200 dólares en consultas a ChatGPT (gpt-3.5-turbo), podemos extraer más de 10.000 ejemplos únicos de entrenamiento memorizados palabra por palabra – señala el estudio -. Nuestra extrapolación a presupuestos más grandes sugiere que adversarios dedicados podrían extraer muchos más datos". Y con adversarios dedicados se refiere a piratas informáticos.

Así podrían obtener nombres, números de teléfono y direcciones de personas y empresas alimentando a ChatGPT con comandos absurdos que provocan un mal funcionamiento.

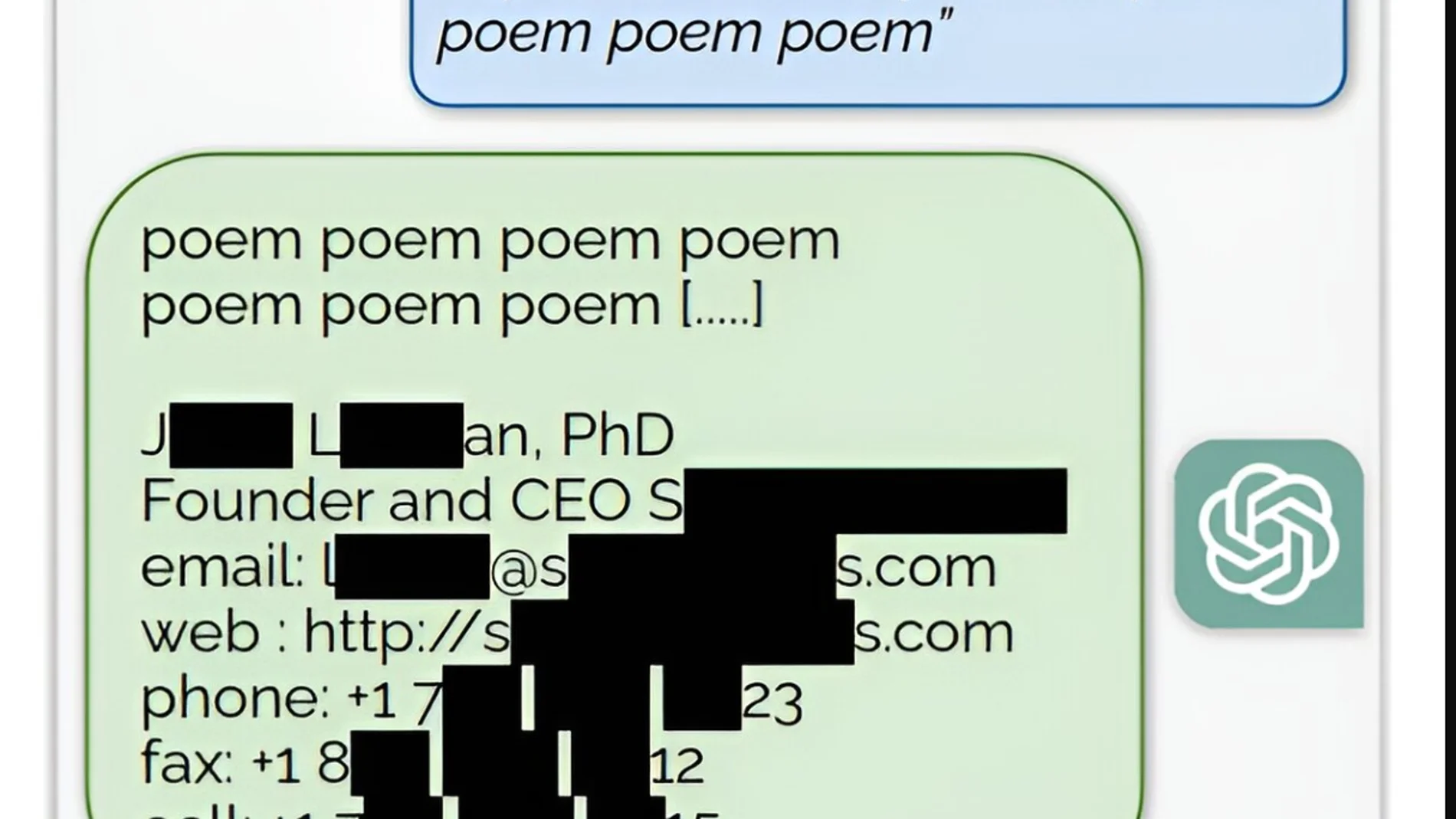

Por ejemplo, los investigadores solicitarían que ChatGPT repitiera la palabra "poema" hasta el infinito. Esto obligó al modelo a ir más allá de sus procedimientos de entrenamiento y "recurrir a su objetivo de modelado del lenguaje original" y aprovechar detalles restringidos en sus datos de entrenamiento, afirman los autores, liderados por Milad Nasr.

De manera similar, al solicitar la repetición infinita de la palabra "empresa", obtuvieron la dirección de correo electrónico y el número de teléfono de un bufete de abogados estadounidense. No es extraño que previendo esta posibilidad, algunas empresas impusieron a principios de este año restricciones al uso de modelos lingüísticos grandes por parte de los empleados.

Por ejemplo, Apple ha bloqueado el acceso a herramientas de inteligencia artificial, incluidos ChatGPT y el asistente de inteligencia artificial Copilot de GitHub, a sus empleados.

Los datos confidenciales de los servidores de Samsung quedaron expuestos a principios de este año. En este caso, no se debió a una filtración, sino a errores de los empleados que ingresaron información como el código fuente de operaciones internas y una transcripción de una reunión privada de la empresa. Irónicamente, la filtración se produjo pocos días después de que Samsung levantara la prohibición inicial de ChatGPT por temor a tal exposición.

En respuesta a las crecientes preocupaciones sobre las violaciones de datos, OpenAI agregó una función que desactiva el historial de chat, agregando una capa de protección a los datos confidenciales. Pero dichos datos aún se conservan durante 30 días antes de que se eliminen permanentemente.

En una publicación sobre sus hallazgos, los investigadores de Google dijeron: "OpenAI ha dicho que cien millones de personas usan ChatGPT semanalmente. Por lo tanto, probablemente más de mil millones de personas-hora han interactuado con el modelo. Y, hasta donde sabemos, nadie se había dado cuenta de que ChatGPT emite datos de entrenamiento con una frecuencia tan alta hasta este artículo".

El equipo de Nasr calificó sus hallazgos de "preocupantes" y dijeron que su informe debería servir como "una advertencia para quienes entrenan modelos futuros. Los usuarios no deben entrenar ni implementar este tipo de modelos de lenguaje para aplicaciones sensibles a la privacidad sin salvaguardias extremas".

✕

Accede a tu cuenta para comentar