Inteligencia artificial

Cómo 'envenenar' tus imágenes para que una IA produzca errores si las usa en su entrenamiento

Nuevas aplicaciones modifican las imágenes de forma no perceptible para el ojo humano, pero que introduce errores en la interpretación que realizan las IA de texto a imagen

Una nueva herramienta permite añadir cambios, invisibles para el ojo humano, en una imagen antes de subirla a Internet, de forma que si una inteligencia artificial de texto a imagen como Midjourney o DALL-E las utilizan en su entrenamiento, provocará errores en su funcionamiento. Se llama Nightshade y el medio MIT Tecnology Review ha tenido acceso a una versión preview de este software que actualmente está siendo revisado por pares en la conferencia de seguridad de computadoras Usenix.

Nightshade es obra del equipo comandado por Ben Zhao, profesor de la Universidad de Chicago, que también desarrolló Glaze, una herramienta similar y que en el futuro pretende integrar con la primera.

Compañías como OpenAI, Meta, Google y Stability AI enfrentan una serie de demandas legales por parte de artistas cuyas imágenes han sido empleadas en el entrenamiento de sus modelos de inteligencia artificial sin su consentimiento o compensación.

Estas herramientas se han entrenado con millones de imágenes procedentes de Internet para adquirir la capacidad de crearlas a partir de las descripciones de texto que introducen los usuarios.

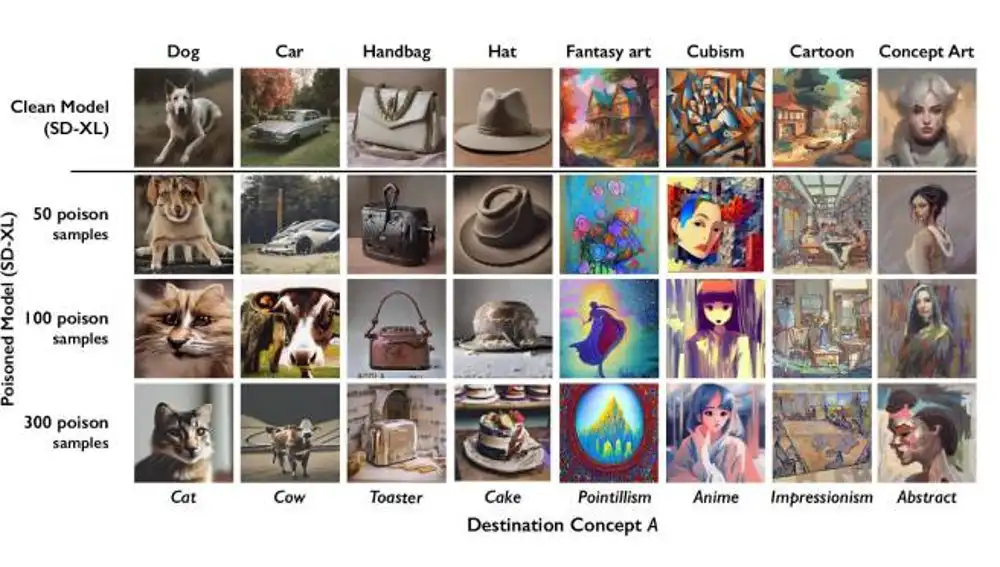

Las imágenes tratadas con Glaze o Nightshade pueden manipular a un modelo de inteligencia artificial para que aprenda, por ejemplo, que las imágenes de perros son de gatos. De forma que cuando posteriormente un usuario pida una imagen de lo primero obtenga lo segundo.

Ambas aplicaciones modifican sutilmente los píxeles de las imágenes, de forma no perceptible a la vista humana, para que los modelos de aprendizaje automático como Stable Diffusion, DALL-E o Midjourney las interpreten como algo diferente a lo que realmente muestran.

No basta con una sola imagen con datos envenenados, lógicamente, cuando la IA se ha entrenado con millones. Pero en pruebas realizadas con Stable Diffusion, bastó con subir 50 imágenes de perros tratadas con Nightshade para que comenzara a arrojar resultados cada vez más irregulares. Tras 300 imágenes envenenadas, ya generaba gatos en lugar de perros cuando se le pedía una imagen de lo último. Cuantas más imágenes envenenadas se suban a una inteligencia artificial, más daño causarán en su funcionamiento. Esto se debe a que aprovechan una vulnerabilidad de seguridad en estos modelos.

La confusión que introducen en los modelos de IA afecta también a las imágenes relacionadas. En este caso, no solo a las de perros sino a las que surjan a partir de descripciones que incluyan términos como “cachorro”, “husky” o “lobo”.

Las compañías detrás de estas herramientas pueden corregir estos malfuncionamientos, pero para ello deben eliminar cada una de las imágenes manipuladas con Nightshade o Glaze, lo que es un proceso tremendamente minucioso.

Zhao cree que estas herramientas “ayudarán a inclinar el equilibrio de poder de las empresas de inteligencia artificial hacia los artistas, al crear un poderoso elemento disuasorio contra la falta de respeto a los derechos de autor y la propiedad intelectual de los artistas”. Admite que estas herramientas podrían ser utilizadas con fines maliciosos, pero los atacantes necesitarían miles de imágenes modificadas para infligir un daño real en los modelos más grandes de texto a imagen.

✕

Accede a tu cuenta para comentar