Futuro

¿Debo preocuparme por la inteligencia artificial?

Un nuevo avance en el campo de la inteligencia artificial hace que nos preguntemos si sus peligros son reales.

Lo nuevo nos inquieta y Mary Shelley nos ha enseñado a desconfiar de nuestras propias invenciones. Ahora, conocemos esa suspicacia como “síndrome de Frankenstein”, el temor a que nuestras creaciones se vuelvan contra nosotros. Algo así sucede con la inteligencia artificial y, como lo primero es el “miedo” y luego viene la justificación, nos encontramos verdaderas películas de ciencia ficción. Cuando algunos escuchan “inteligencia artificial”, erizan los pelos de su nuca imaginando un escenario postapocalíptico en el que robots casi omniscientes hostigan a los últimos supervivientes de la humanidad.

Otros, tal vez menos fantasiosos, se preocupan porque esta tecnología pueda llegar a dejarnos sin trabajo. Tal vez esta última preocupación tenga más sentido a corto plazo, pero parece bastante plausible que, con una regulación adecuada, no suponga un problema a medio y largo plazo, a medida que el mercado se adapte y comience a buscar otros valores en sus trabajadores.

Miedo el justo

Tal vez, los miedos más realistas son aquellos relacionados con el impacto social más directo de esta tecnología. Sabemos, por ejemplo, que la información con la que se entrene a una inteligencia artificial condicionará su manera de operar. Si las fuentes de imágenes que toma están sesgadas hacia un sexo o una raza, sus resultados también lo estarán, invisibilizando o incluso discriminando a esos perfiles. Son innumerables los casos de inteligencias artificiales que han sido entrenadas sin preocuparnos por esos detalles y cuyos sesgos han llegado a abrirse camino hasta el mercado.

Esa es la consecuencia del avance tecnológico desbocado, y ya decía Asimov que lo más triste de nuestra época es que la ciencia gana en conocimiento más rápido que la sociedad en sabiduría. Para paliarlo, por suerte, contamos con una serie de disciplinas en auge que comienzan a prestar atención a esta tecnología, ya sea desde la ética, el derecho, la sociología e incluso la psicología. Esto no quiere decir que debamos bajar la guardia, pero sin lugar a duda da cierta esperanza en cuanto a que podamos esquivar ciertos inconvenientes de las inteligencias artificiales. Y, ya que lo más plausible parece estar más o menos controlado, cabe preguntarnos por aquel escenario fantasioso de hace unos párrafos. ¿Nos ha de preocupar una dictadura de las máquinas?

¿Y por qué no?

Los expertos en inteligencia artificial y los comunicadores especializados en ella están bastante de acuerdo, el consenso es que no debemos preocuparnos porque la inteligencia artificial acabe dominándonos. Sin embargo, no siempre se dan buenos argumentos al respecto y, más veces de las debidas, nos quedamos con la sensación de estar ante un argumento de fe. Puede parecernos que, si seguimos mejorando nuestras inteligencias artificiales hasta que estas sean capaces de mejorarse a sí mismas, nada las privará de tomar conciencia, extenderse y tomar el control, pero a poco que rasquemos encontramos varios problemas con este tema.

Por un lado (y espero que nadie se asuste), muchas inteligencias artificiales ya se mejoran a sí mismas. En cierto modo, esa es parte de la clave de su éxito, que son capaces de adaptarse para mejorar su rendimiento. Sin embargo, en esa frase se esconde un argumento para la tranquilidad, porque… ¿su rendimiento para qué? Por suerte la respuesta es: para lo que queramos. Por lo general, esas magníficas inteligencias artificiales que atraen la atención del gran público por ser capaces de vencer a expertos en ajedrez o en videojuegos, esas que pueden escribir artículos, conducir coches o pintar cuadros, no pueden hacer todo a la vez. Es lo que conocemos como “inteligencia artificial débil” o “estrecha”, capaz de superarnos en una tarea concreta, pero absolutamente incapaz de adaptarse a otras. Por ejemplo, una inteligencia artificial capaz de ganar a mejor ajedrecista del mundo posiblemente no pueda aprender a jugar a las damas (sin desaprender cómo jugar al ajedrez).

Este es un buen argumento, en principio. En cierto es incluso mejor que el de “siempre podemos desconectarla y punto”, que, aunque suele formularse de manera ingenua, responde a una serie de mecanismos de seguridad reales con los que podemos contar. Una inteligencia hecha para conducir no empezará a dominar el mundo. ¿O sí?

Un nuevo propósito

Si le preguntáramos a Elon Musk, no estaría tan seguro, y es que en sus últimas declaraciones ha afirmado que el verdadero éxito de los coches autónomos estará en que dejen de estar controlados por una inteligencia artificial estrecha y pasen a ser dirigidos por una inteligencia artificial de propósito general. La cantidad de subtareas visuales, motrices e incluso lingüísticas que requeriría un coche realmente autónomo son tales que podrían considerarse como problemas diferentes. Para obtener la excelencia en todos, tal vez haría falta una nueva aproximación, una tecnología más parecida a la inteligencia artificial de la ciencia ficción, capaz de superarnos (o al menos igualarnos) en multitud de tareas diferentes.

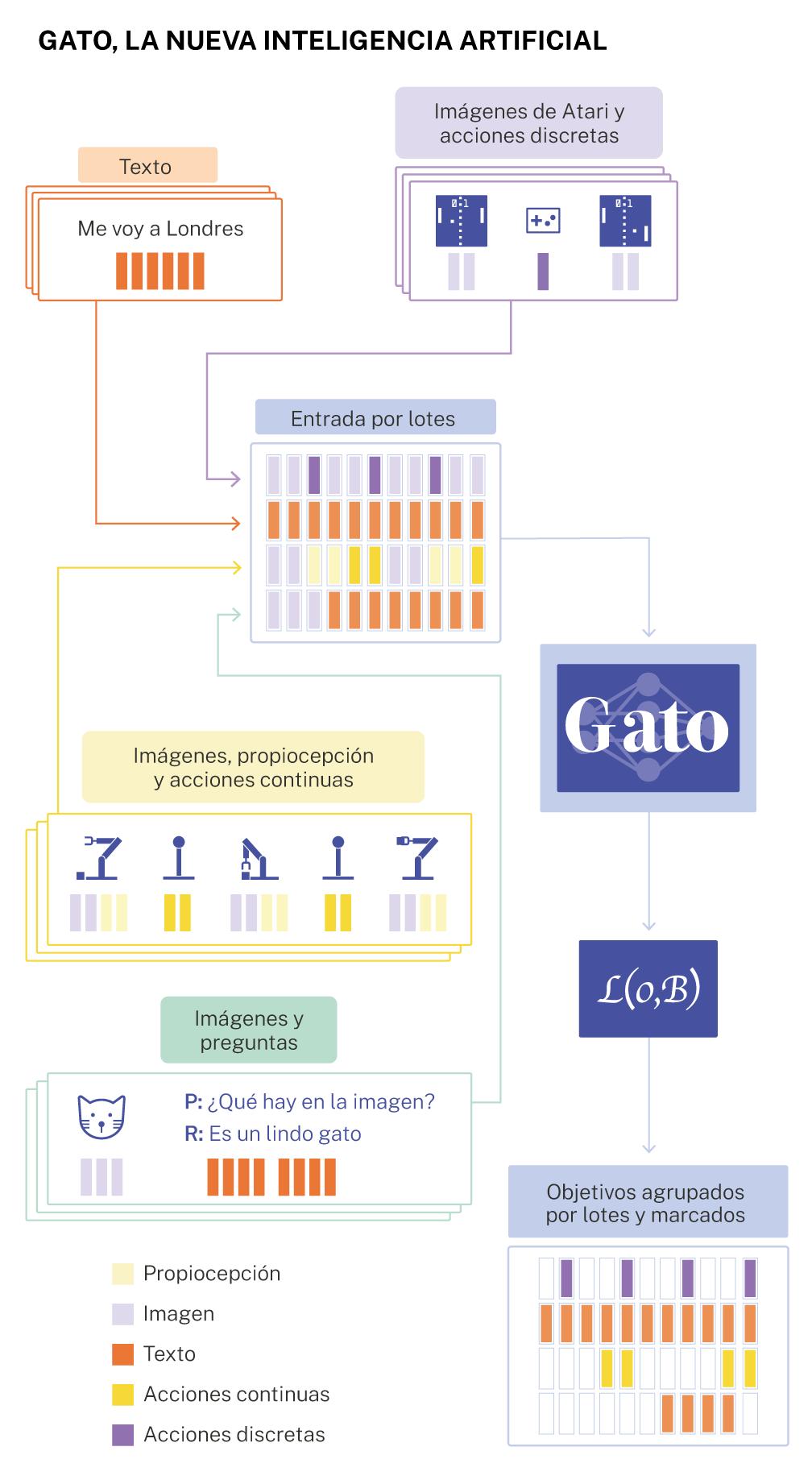

Hasta ahora, esta cuestión solía responderse diciendo que estamos muy lejos de lograr una inteligencia artificial de propósito general realmente funcional y, aunque no le falta cierta razón, los años han ido acortando esa distancia. Sin ir más lejos, DeepMind acaba de presentar “Gato”, una inteligencia artificial capaz de jugar a videojuegos, identificar imágenes, manipular un brazo robótico para que apile cajas e incluso chatear con humanos. Cierto es que su desempeño es relativamente mediocre en todas estas tareas (salvo, tal vez, en cuanto al brazo robótico, en lo que destaca). Y, de hecho, Gato no es la única inteligencia artificial de este tipo. Para algunos, la famosa GPT-3, tan versátil como es, ya abarcaba suficiente como para considerarla como tal. Y, más allá de la posible polémica sobre cómo considerar a GPT-3, existe un consenso sobre que Google presentó algo cercano a una inteligencia artificial de propósito general el pasado verano con su “Perceiver”.

Es cierto que, como hemos visto, son buenos ejemplos de que, quien mucho abarca poco aprieta, pero los expertos sugieren que sus mayores hándicaps pueden resolverse de forma natural según aumente la capacidad de computación de los ordenadores, permitiendo entrenamientos mucho más masivos. Dicho de otro modo: a medida que aumente la potencia de los ordenadores mejorará el desempeño de las inteligencias artificiales y, aunque posiblemente las estrechas sigan siendo mejores en tareas concretas, las “generales” que avancen por este camino iniciado por Perceiver y Gato, serán suficientemente competentes como para llegar al mercado.

El peligro somos nosotros

¿Qué sucederá pues con estas nuevas inteligencias? Por supuesto, no podemos saberlo, pero ese peligro apocalíptico tampoco parece demasiado preocupante. Por generales que sean (en parte), siguen consistiendo en matemáticas sin voluntad, sin un propósito más allá del que nosotros les pongamos. Aunque parezca mentira, parece que estamos desarrollando una conciencia social inusitada en lo que a las implicaciones de las nuevas tecnologías se refiere. Esto, junto con el nuevo interés en abordar la inteligencia artificial desde la ética y el derecho nos permitirán limitar nuestra creación de modo que no nos ponga en peligro, ya sea de forma preventiva o mediante alguna medida de seguridad extrema.

Y es que, al final, el peligro por el que más debemos preocuparnos no está intrínsecamente en la inteligencia artificial, en que sea capaz de cobrar conciencia y surja en ella la voluntad de dominar a la raza humana. El verdadero peligro está en nosotros, en cómo pretendemos utilizarla y lo descuidados que podamos ser por estar embelesados por el cegador brillo del progreso.

QUE NO TE LA CUELEN:

- Otro problema del que no se suele hablar son los recursos energéticos que consume esta tecnología y la contaminación que supone. Sin embargo, una buena forma de enfrentar el problema sería poner especial esfuerzo en crear redes neuronales más eficientes en términos de programación, esto es, con instrucciones más claras, menos redundantes, que minimicen la cantidad de energía requerida. El problema es que esto ya se hace en gran medida, y no tanto por el medio ambiente, sino para reducir sus costes y agilizar su funcionamiento. Puede mejorarse, pero posiblemente sea la forma más avanzada para reducir el impacto de las IAs.

REFERENCIAS (MLA):

✕

Accede a tu cuenta para comentar

La coalición, en precampaña