Regulación

La IA vuelve a enfrentar a las tecnológicas y la UE

Grandes compañías aseguran que la excesiva regulación les impedirá traer su tecnología a Europa

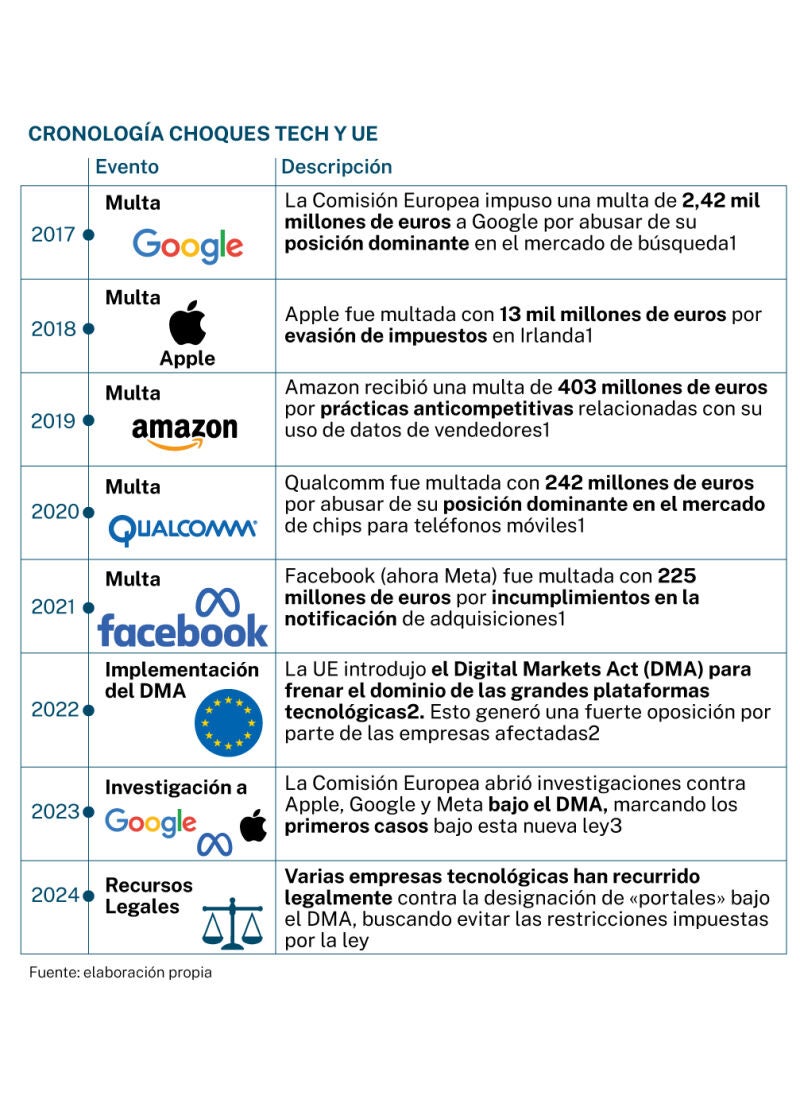

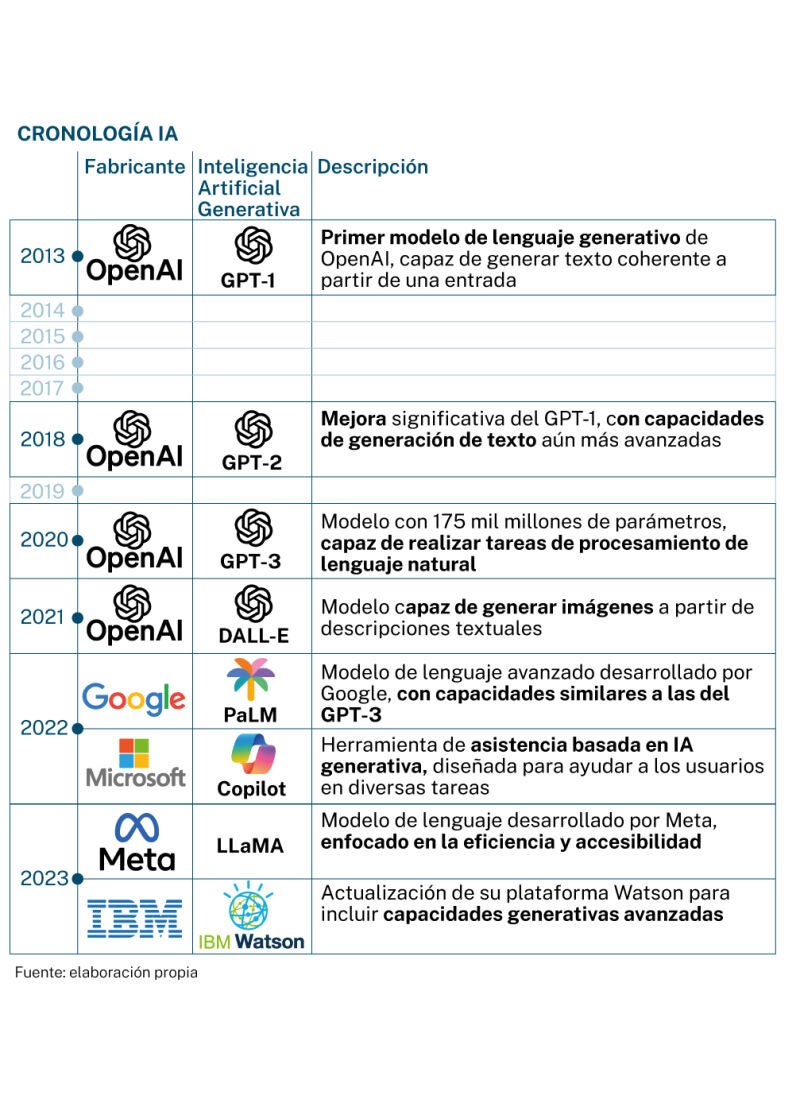

Hay quien dice que EE UU inventa, China copia y la Unión Europea regula. Independientemente de todos los matices que se pueden poner a dicha afirmación, las regulaciones de la Unión Europea la han enfrentado, y en no pocas ocasiones, con las empresas tecnológicas (que, en su mayoría, provienen del otro lado del charco). La Inteligencia Artificial (IA), el uso de los datos (más allá de su protección con RGPD) y el Digital Markets Act (DMA, sobre mercados digitales) es el nuevo escenario de batalla, en el que unos (los europeos) aseguran que están anteponiendo a los usuarios mientras los otros (las tecnológicas) alertan del peligro de que los ciudadanos de este continente se queden fuera de las innovaciones.

Las regulaciones europeas son estrictas en lo que al uso de los datos, especialmente de sus ciudadanos, se refiere. Y ya han sido numerosas (y cuantiosas) las multas que se han impuesto.

En enero entraba en vigor el DMA, que establece obligaciones y prohibiciones para las plataformas tecnológicas consideradas «portales» debido a su enorme influencia en el mercado. Mientras que la Comisión Europea defiende el DMA como una medida necesaria para garantizar la competencia y la innovación en el sector digital (ya que busca crear un entorno más equilibrado donde las pequeñas y medianas empresas puedan competir de manera justa con las grandes plataformas), las afectadas aseguran que precisamente lo que se merma es la competitividad.

El DMA afecta, de lleno, al desarrollo e implantación de la IA, ya que impone requisitos de transparencia sobre cómo las plataformas tecnológicas cómo recopilan, utilizan y comparten datos para entrenar modelos. Además, deben compartir ciertos datos con competidores bajo una serie de condiciones específicas. La UE argumenta que esta obligación podría democratizar el acceso a estos datos y fomentar la innovación en el sector de la IA.

Me planto

Esto ha provocado que algunas empresas hayan dado un puñetazo encima de la mesa y se nieguen a ofrecer algunas de las prestaciones de IA en la UE.

Para Richard Benjamins, experto en ética e IA, dado que las empresas Big Tech tienen que respetar las leyes de la Unión Europea, «hacen bien en no entrar hasta que sepan si cumplen o no» con la legislación, «para que no entren servicios con cierto riesgo ético y social sin las necesarias salvaguardas, y por otro lado para evitar multas importantes», reflexiona.

Aunque fuentes de Apple aseguran que su tecnología sí está accesible en fase beta, también dejan claro que no lo está en sus dispositivos por la designación de iOS y iPadOS bajo la DMA). Fuentes de la compañía, no obstante, aseguran que están en conversaciones con la Comisión Europea para comprender los requisitos reglamentarios.

En el caso de Meta, la confrontación viene después de que la compañía anunciara que, salvo que sus usuarios lo negaran explícitamente, utilizarían todo el contenido que han publicado de manera abierta (nunca, por ejemplo, a través de mensajes privados) en sus redes sociales para entrenar sus modelos.

La compañía no solo defiende la legalidad de todas sus actuaciones en este sentido, sino que remarca que si no entrenan sus modelos con este contenido público, estos modelos y las características de IA «no comprenderán con precisión cuestiones como los idiomas regionales importantes, las culturas o los temas de tendencia en las redes sociales» y, por lo tanto, los ciudadanos de Europa tendrán unos peores modelos de IA y una peor experiencia.

«Los modelos pueden ser entrenados en las publicaciones compartidas públicamente de las personas, pero no es una base de datos de la información de cada persona ni está diseñada para identificar a ningún individuo. Más bien, estos modelos se construyen mirando la información de las personas para identificar patrones, como comprender frases coloquiales o ciertas referencias locales, no para identificar a una persona específica o su información», defiende.

Tecnológicas europeas

Al igual que pasó con el desarrollo del reglamento de protección de datos, ahora son también muchas las compañías europeas que apoyan a sus colegas estadounidenses en esta confrontación con los reguladores.

Spotify, Ericsson o Klarna son algunas de las compañías que han firmado una carta pública en la que sostienen que la UE no tiene normas coherentes por lo que, o cambian las tornas, o «se van a perder dos piedras angulares de la innovación en la IA»: los modelos «abiertos» y los modelos «multimodales». Los abiertos son los que se ponen a disposición de todo el mundo, sin coste, para que se usen, modifiquen y construyan. «Los modelos abiertos fortalecen la soberanía y el control al permitir que las organizaciones descarguen y ajusten los modelos donde quieran, eliminando la necesidad de enviar sus datos a otro lugar», asegura la misiva. Mientras, los multimodales son capaces de funcionar con fluidez en texto, imágenes y voz, por lo que son «el próximo salto en IA. La diferencia entre los modelos de solo texto y los multimodales es como la diferencia entre tener solo un sentido y tener los cinco».

Son los datos

Álvaro Higes es el CEO de Luzia, una aplicación desarrollada en España desde hace un año, que emplea la IA y que en estos escasos meses ha conseguido 30 millones de financiación. El hecho de que algunas empresas no quieran traer su IA a Europa les afecta y de forma negativa. «No tener acceso a las mejores herramientas (por ejemplo, Llama 3.2 multimodal, o el modo de voz avanzado de OpenAI –en el momento de escribir este artículo está solo disponible para enterprise customer–) limita nuestras capacidades para innovar y competir en igualdad de condiciones», asegura a LA RAZÓN.

Higes también está de acuerdo en que el exceso de regulación puede ser un freno para la innovación. «La IA es una tecnología en evolución, y sobrerregularla puede llevar a Europa a quedar fuera de la carrera por el desarrollo y aplicación de IA», señala. Pero también concede que las empresas «deben ser más transparentes y colaborar en este proceso». «Entiendo la preocupación europea por proteger a los ciudadanos y garantizar un uso ético y seguro de la IA. Sin embargo, creo que en algunos puntos se está intentando regular demasiado pronto, sin tener un conocimiento completo de cómo evoluciona esta tecnología», subraya.

Mientras, esta situación podría ser una oportunidad, según Marlon Cárdenas, Head of Data Science en Sopra Steria España. «Al restringir la entrada de gigantes tecnológicos se crea espacio para que startups y compañías de la región desarrollen soluciones alineadas con los valores de la UE». Algo que podría impulsar una industria más centrada en la ética, la privacidad y la seguridad», frente al modelo estadounidense que «prioriza el crecimiento y la experimentación, a veces sin preocuparse de los riesgos».

[[H2:El «efecto Bruselas» y un futuro ganador]]

En este nuevo choque de titanes, ¿quién acabará cediendo? Para Richard Benjamins, experto en ética e IA, serán las tecnológicas. «El mercado de la UE es demasiado apetecible (440 millones de posibles clientes de alto poder adquisitivo) como para que se puedan permitir no entrar. Entrarán seguro». Es el«efecto Bruselas». «Para estas empresas es más costoso operar distintos servicios en distintas geografías que operar solo de una manera», explica. Por eso, aunque puede que lleguen más tarde, acabarán aplicando los mismos criterios en todo el mundo.

✕

Accede a tu cuenta para comentar