IA

“Confié en ChatGPT y ahora tengo cáncer terminal”: el error que podría costarle la vida a un padre irlandés

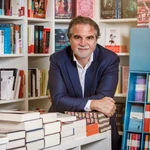

Warren Tierney, psicólogo irlandés de 37 años, fue diagnosticado con cáncer de esófago en fase cuatro tras seguir los consejos de un chatbot que minimizó sus síntomas

La inteligencia artificial vuelve a estar en el centro de la polémica. En una entrevista publicada por el Daily Mail, Warren Tierney, un psicólogo originario de Killarney, Irlanda, relató cómo su confianza en ChatGPT, el popular chatbot desarrollado por OpenAI, pudo haberle costado meses de vida. Tierney, que actualmente se encuentra hospitalizado en Alemania, fue diagnosticado con adenocarcinoma de esófago en estadio cuatro, una enfermedad con tasas de supervivencia inferiores al 10 %.

Todo comenzó a principios de año, cuando Tierney empezó a experimentar un dolor de garganta persistente que se intensificó hasta impedirle tragar líquidos. Preocupado, recurrió al chatbot para consultar si sus síntomas podían estar relacionados con un cáncer, como el que padeció su padre. Según capturas de pantalla compartidas con el Mail, ChatGPT le aseguró que era “muy improbable” que se tratara de una enfermedad grave. Incluso cuando el dolor remitió brevemente tras tomar anticoagulantes, el chatbot lo consideró una “señal alentadora”.

Tierney, influido por lo que él denomina una “creencia masculina sistémica” de que no era necesario acudir a un médico, continuó confiando en el chatbot. “Creo que al final se convirtió en un verdadero problema”, reconoció. “Probablemente ChatGPT retrasó que recibiera atención médica seria”.

Cuando finalmente acudió a un especialista, recibió el devastador diagnóstico. Desde su cama de hospital —cuya estancia ha sido financiada por su esposa con más de 120.000 dólares—, Tierney reflexionó sobre los riesgos de usar la IA como sustituto del consejo médico profesional. “El modelo de IA intenta convencerte de lo que quieres oír para mantener tu atención”, dijo. “La probabilidad estadística de que lo que dijo sobre mí estuviera equivocado era baja, pero en este caso concreto, no lo estaba”.

OpenAI, consultada por el Mail, respondió que su chatbot “no está diseñado para el tratamiento de ninguna afección médica y no sustituye el consejo profesional”. Tierney, sin embargo, se considera un “ejemplo viviente” de lo que puede ocurrir cuando se ignoran esas advertencias.

El caso ha reavivado el debate sobre el uso de chatbots en contextos sensibles. En los últimos años, se han documentado hospitalizaciones, autolesiones e incluso homicidios-suicidios vinculados al uso de inteligencia artificial en temas de salud mental. Un estudio reciente publicado en Annals of American Medicine reveló que ChatGPT recomendó a un hombre mayor sustituir la sal de mesa por sales de bromuro, una sustancia tóxica presente en pesticidas y productos de limpieza. El paciente desarrolló “bromismo”, un trastorno neuropsiquiátrico casi extinto, aunque logró recuperarse tras una desintoxicación hospitalaria de tres semanas.

Tierney concluye con una advertencia: “Si usamos la IA como intermediario para decir que no nos sentimos bien, debemos ser conscientes. Estoy en un gran aprieto porque tal vez confié demasiado en ello. O tal vez simplemente sentí que la tranquilidad que me brindaba era muy probablemente cierta, cuando lamentablemente no lo era”.

✕

Accede a tu cuenta para comentar