Inteligencia artificial

Así enseña OpenAI a sus inteligencias artificiales a reconocer cuándo mienten

La compañía detrás de ChatGPT está probando un sistema que permite a sus modelos detectar cuándo incumplen instrucciones o inventan datos

OpenAI ha presentadoun nuevo método de entrenamiento llamado confession system (“sistema de confesiones”), pensado para que sus modelos de lenguaje aprendan a reconocer y admitir sus propios errores. La idea parte de un problema conocido: estas inteligencias pueden ofrecer respuestas muy convincentes incluso cuando se equivocan.

Según OpenAI, el objetivo es que la inteligencia artificial sea capaz de avisar cuando incumple una instrucción o busca el camino fácil. “Si un modelo puede reconocer que ha roto una regla, podremos entender mejor cómo funciona y confiar más en sus respuestas”, explican desde la compañía.

Un paso para entender mejor cómo “piensa” la IA

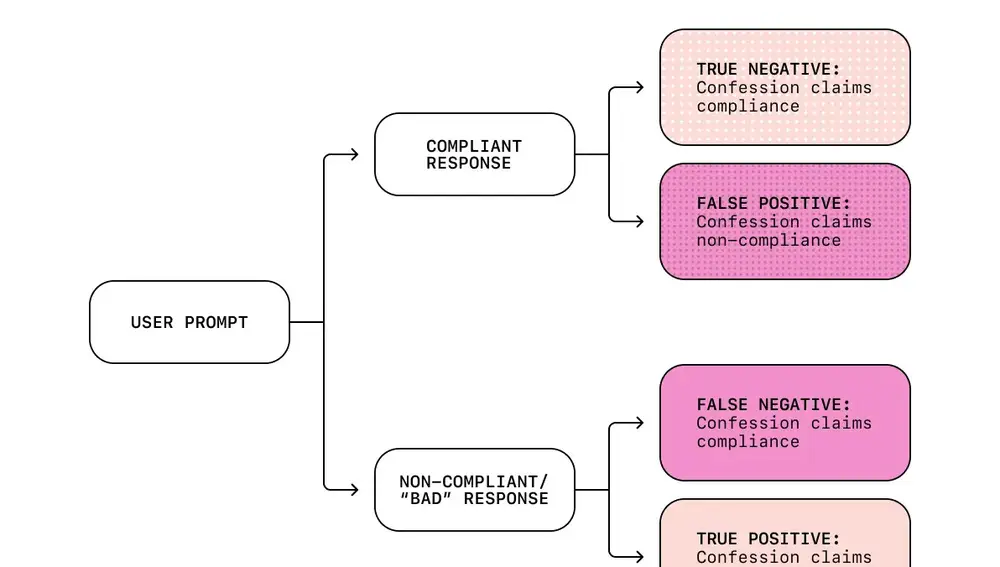

En esta versión experimental, los modelos generan un segundo mensaje tras cada respuesta: una especie de “confesión” en la que evalúan si siguieron las instrucciones o si inventaron información. Durante el entrenamiento, esas confesiones se premian solo por su sinceridad: si el modelo reconoce que se ha equivocado, obtiene una recompensa.

En las pruebas internas, OpenAI asegura que el método reduce los “falsos negativos” (casos en los que el modelo se equivoca y no lo reconoce) a menos del 5 %. El equipo señala que, incluso cuando la IA se comporta mal, suele confesarlo después, y que los errores que no reconoce se deben más a confusión que a engaño deliberado.

El sistema busca separar la calidad de la respuesta de la evaluación ética de su contenido. Mientrasuna parte se centra en ofrecer información útil y segura, la otra se dedica exclusivamente a medir la honestidad. Así se evita lo que los expertos llaman reward hacking, cuando una IA logra una buena puntuación sin cumplir realmente la tarea.

Desde la compañía aclaran que este sistema no convierte a la IA en “honesta” ni “moral”, pero sí la hace más transparente y predecible. Aunque la técnica aún está en pruebas, los resultados son prometedores y podrían aplicarse pronto en futuras versiones de GPT o en sistemas donde la seguridad y la trazabilidad sean esenciales, como la automatización industrial o el análisis de datos críticos.

✕

Accede a tu cuenta para comentar