Ingeniería

El software que reconoce manos

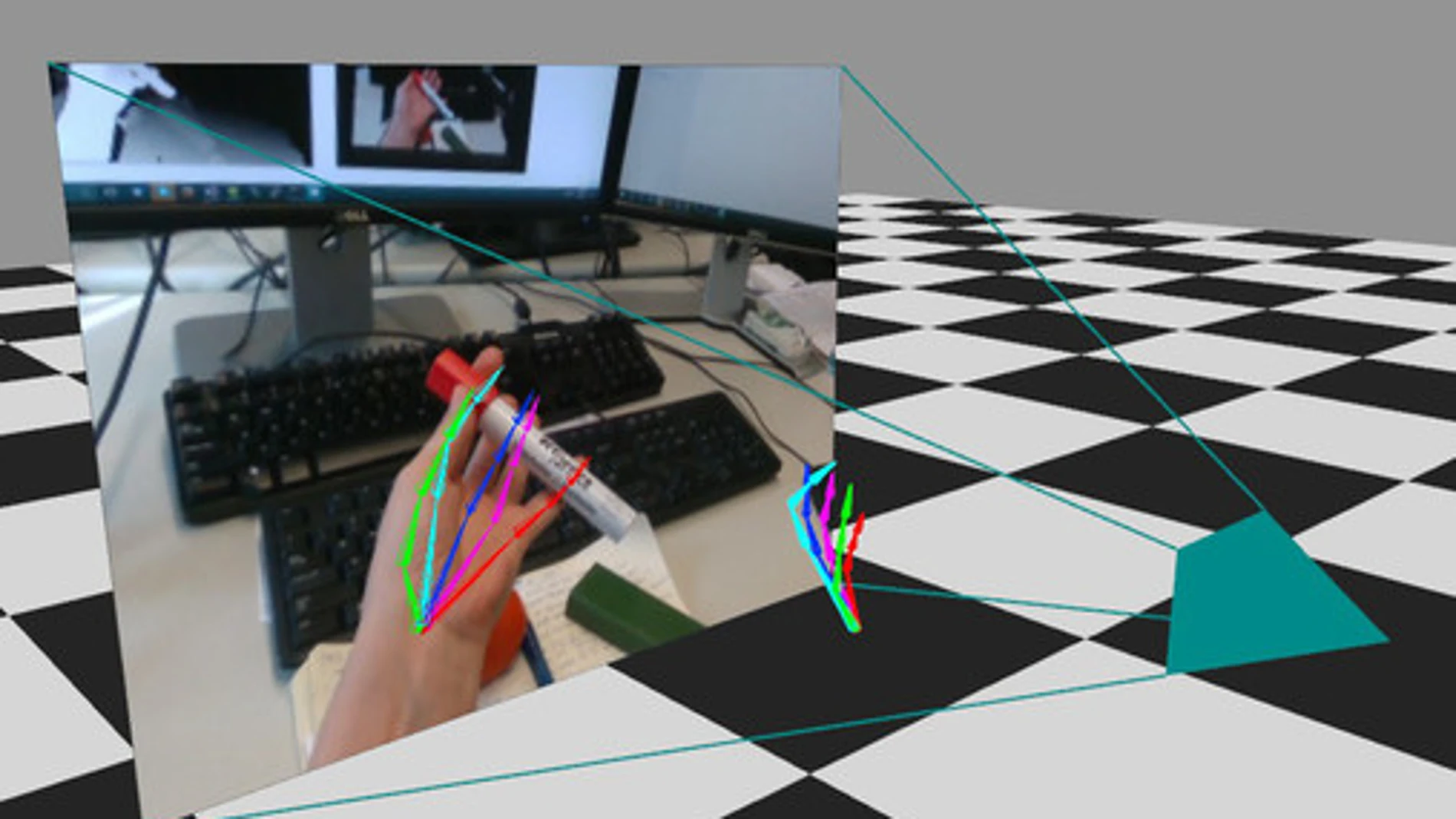

Un equipo de investigadores europeos, en el que participado la Universidad Rey Juan Carlos, ha desarrollado un algoritmo que detecta la posición tridimensional de una mano en tiempo real mediante imágenes de vídeo. El avance abre las puertas al control remoto mediante gestos y a nuevas formas de interacción con mundos virtuales

Conseguir que un ordenador reconozca los movimientos y posición de las manos ha sido un gran reto informático que hasta ahora requería cámaras especializadas o dispositivos que grabaran desde varios ángulos.

En este contexto, investigadores de la Universidad Rey Juan Carlos (URJC) han participado en un proyecto de investigación, liderado por el Instituto de Informática Max Planck de Alemania, para desarrollar un método que consigue identificar la posición de todos los dedos y articulaciones de una mano en tiempo real a partir de vídeos.

“Este adelanto abre las puertas a todo tipo de control remoto de manera gestual, estudio de movimiento de manos e interacción con mundos virtuales”, destaca Dan Casas, investigador Marie Curie del Laboratorio de Simulación Multimodal de la URJC.

La nueva tecnología, presentada en la Conferencia de Visión por Computador y Reconocimiento de Patrones (CVPR, por sus siglas en inglés) en Utah (EEUU) el pasado mes de junio, permitirá que podamos subir el volumen de la radio o cambiar de emisora de manera precisa sin necesidad contacto. Además, este algoritmo contribuirá a mejorar la animación y el manejo de videojuegos y entornos de realidad virtual, ámbitos en los que la URJC es pionera.

Por otra parte, el reconocimiento de manos podría utilizarse en otros ámbitos como la medicina para mejorar el control de dispositivos de cirugía remotos o detectar problemas de salud, como estrés o depresión, a partir de los gestos de los pacientes. Esta herramienta también ofrece nuevas posibilidades para la interpretación digital de la lengua de signos.

Visualizar de manera digital la posición de las manos es una tarea especialmente complicada debido a que cada mano cuenta con un gran número de articulaciones, a la velocidad con la que las movemos y, sobre todo, a la estimación de la profundidad a partir de una imagen bidimensional. “En un vídeo en el que aparece una mano moviéndose de forma natural, en la mayoría de fotogramas parte de los dedos están tapados por otros dedos”, explica Casas.

Un algoritmo para aprender

Para resolver este problema, los investigadores utilizaron un algoritmo de aprendizaje automático capaz de ‘aprender’ a base de observar muchos ejemplos, como subraya Dan Casas: “Es un comportamiento parecido al de los propios humanos. Ante una nueva tarea, como andar, somos capaces de imitarla a base de observar e intentarlo muchas veces”.

El entrenamiento de este algoritmo supuso gran cantidad de fotogramas en los que se indicaban la posición de cada una de las articulaciones de las manos. Incluso, llegaron a inventar otro algoritmo que generara imágenes realistas de manos para este propósito.

Este estudio ha conseguido que, por primera vez en el campo de la visión por computador e inteligencia artificial, seamos capaces de detectar de manera inmediata dónde están todos los dedos de una mano en movimiento a partir de material tan accesible como vídeos grabados con móvil, webcam o procedentes de YouTube.

✕

Accede a tu cuenta para comentar