Avance científico

Un paciente con ELA avanzada volverá a hablar

Es la primera vez que se logra que enfermos con esclerosis lateral amiotrófica avanzada que han perdido toda la capacidad de movimiento puedan comunicarse a través de un implante cerebral

Desde hace años la ciencia ha intentado desarrollar herramientas que pudieran resolver el problema de incomunicación que sufren los pacientes con Esclerosis Lateral Amiotrófica (ELA).

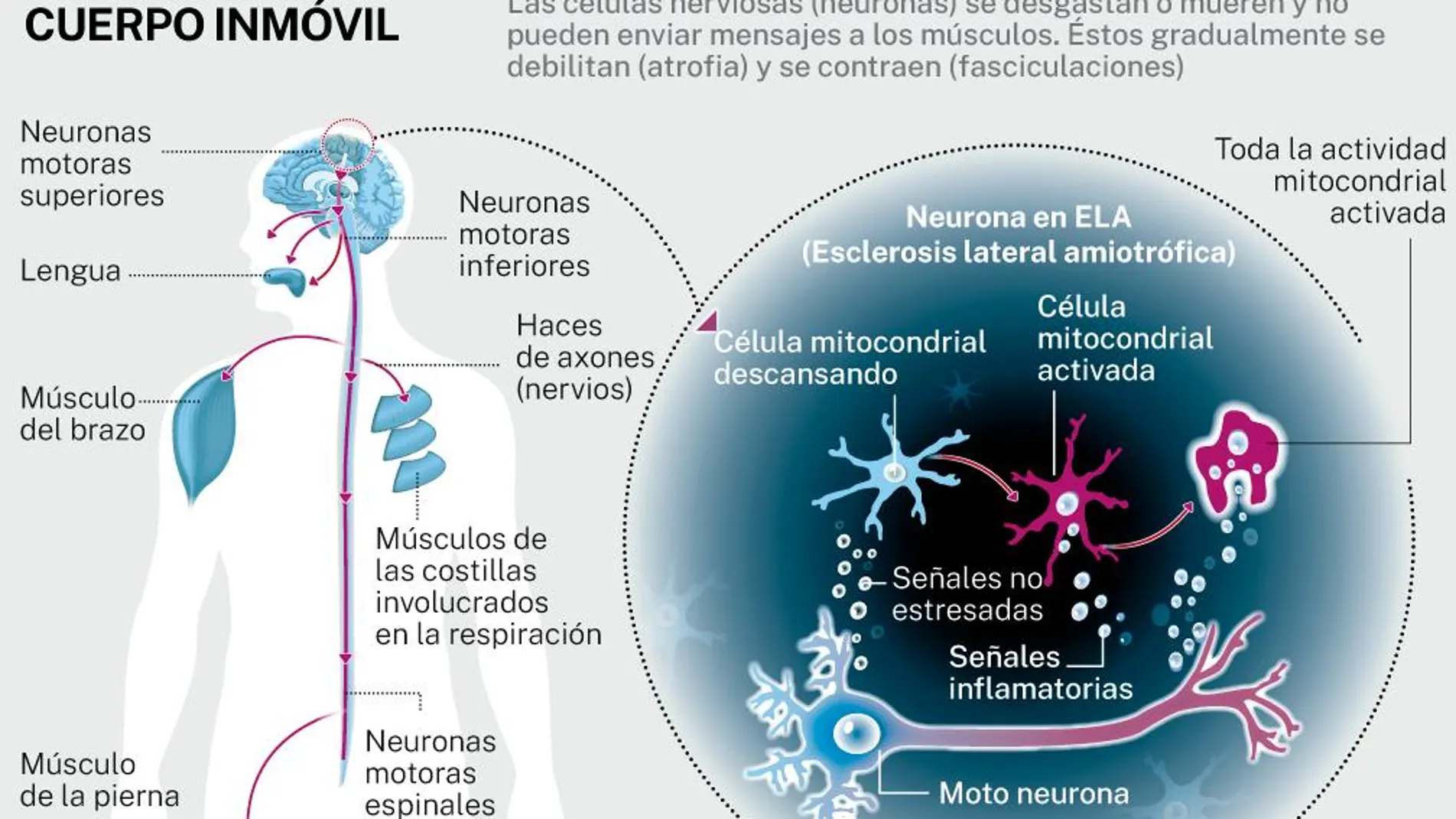

Esta enfermedad cursa provocando una parálisis muscular progresiva. La capacidad para controlar las diferentes partes de su cuerpo con la precisión habitual va disminuyendo al mismo tiempo que dejan de articular palabras. Las motoneuronas, que suelen ser las últimas en disminuir su funcionamiento, son las que controlan los músculos extrínsecos del ojo.

Pero, ¿qué ocurre cuando el paciente pierde el control muscular y no es capaz de comunicarse a través del movimiento de ojos? Sobre esta cuestión ha trabajado un equipo de científicos liderado por el Centro Wyss Center de Neuroingeniería (Suiza) y la Universidad de Tübingen (Alemania). Ayer, la revista «Nature» publicó el esperanzador resultado de su estudio: han logrado que una persona con parálisis total e incapaz de hablar se comunique a través de un dispositivo implantado en el cerebro. Este método se ha desarrollado en un paciente de ELA de 34 años de edad, afectado por el llamado síndrome de cautiverio total (CLIS). En su caso, la parálisis es absoluta.

Sin embargo, su cerebro no había perdido la capacidad para generar comandos para la comunicación. El equipo liderado por Jonas Zimmermann, neurocientífico del Centro Wyss de Ginebra, recurrió a un dispositivo interfaz cerebro-computador (BCI, por sus siglas en inglés) de retroalimentación auditiva (neurofeedback), que consiste de dos microelectrodos intracorticales implantados quirúrgicamente en la corteza motora. Estos electrodos envían señales cerebrales al BCI y éste las decodifica para formar letras, en un proceso que los expertos denominan «sistema auditivo de neurorretroalimentación».

Esta herramienta de inteligencia artificial «mapea» las señales para atribuirles un significado de «sí» o «no» y, para descifrar lo que el participante quiere comunicar, un programa de deletreo enuncia en alto las letras del alfabeto. Y aquí entra en juego el «neurofeedback auditivo», pues el sujeto es capaz de elegir, tras identificar el tono y la frecuencia del «feedback», entre el «sí» o el «no» para confirmar o descartar una letra, hasta formar palabras y frases completas a una velocidad de en torno a un carácter por minuto.

Durante dos años de trabajo, este individuo aprendió a generar actividad cerebral probando diferentes movimientos, señales cerebrales que son detectadas por los microelectrodos y después descodificadas por un modelo de aprendizaje automático en tiempo real.

«Previamente se ha logrado una comunicación exitosa a través de BCIs en personas con parálisis. Pero creemos que nuestro estudio es el primero que logra una comunicación en sujetos que han perdido toda la capacidad de movimiento y, por tanto, este BCI es su único medio de comunicación».

Hasta este momento han sido varios los intentos por desarrollar una tecnología que permitiese hablar a aquellos pacientes que habían perdido dicha capacidad. Estas soluciones se basan en el movimiento de los ojos o músculos faciales, como es el caso de GazeSpeak, una app móvil de inteligencia artificial (IA) desarrollada por investigadores de la Universidad de Washington y de Microsoft. Esta solución captura e interpreta los movimientos oculares convirtiéndolos en el habla. Esta aplicación se ejecuta a través de un smartphone. La persona con la que queremos comunicarnos sujeta el móvil mirando a la pantalla y dejando la parte de atrás del teléfono visible y cerca de la persona que quiere hablar. Éste, mirando a la pegatina instalada en la parte posterior del móvil y que contiene una cuadrícula, irá buscando y seleccionando con los ojos las letras que necesita en los diferentes grupos de palabras. El teléfono registra los movimientos oculares y los traduce en letras.

Otro sistema es Tallk, una propuesta desarrollada por Irisbond, Samsung y la Fundación Luzón. Se basa en algoritmos e inteligencia artificial, utiliza la cámara integrada en las tablets Samsung para analizar la mirada y permitir a los usuarios escribir y expresarse a través de un teclado virtual y una voz sintética. La tecnología de «Eye tracking» de Tallk utiliza la cámara de la tablet para localizar las pupilas y ciertos puntos característicos del rostro para que el software traduzca el movimiento de los ojos en movimientos aproximados dentro de la pantalla para acceder a un teclado virtual y convertir en voz el texto introducido por el usuario. Los usuarios de Tallk pueden usar sus ojos para escribir con un teclado virtual.

✕

Accede a tu cuenta para comentar